Digitales Journal für Philologie

Code und Kritik

Code – Die Sprache unserer Zeit?

Mit dem Aufkommen des Computers als alltäglichem Arbeitsgerät verändert sich die Literatur. Gedruckter Text, bis dato primär im Buch materialisiert und dort dem statischen Gesetz der Linearität aufeinanderfolgender Zeilen und Seiten unterworfen, wird ›befreit‹ – und zwar in mehrfacher Hinsicht. Zunächst geschieht das Offensichtliche: Buchstaben, Worte und Sätze werden auf dem Bildschirm in Bewegung versetzt. Aber auch auf Projektionsleinwänden in räumlichen Medieninstallationen wird Text zur erlebbaren Umgebung. Durch diese neuen Erscheinungsformen entstehen Rezeptionshaltungen, die das kognitive Verstehen von Zeichenfolgen als sinnhafte Botschaften durch spielerische Interaktionen ergänzen, teilweise sogar zu sinnlichen und gesamtleiblichen Erfahrungen werden lassen, die neue Interaktionsräume eröffnen. Diese gestalterischen Dimensionen und ihre Folgen für die Rezipierenden sind gerade zum Ende der 1990er-Jahre und zum Beginn der 2000er-Jahre vielfältig erforscht worden.1 Dadurch verändert sich auch der Blick auf die Geschichte von Schrift und Sprache, da Traditionen der Überschreitung des Buches verstärkt in den Blick genommen werden: Denn derartige sinnliche und performative Erweiterungen und Veränderungen der Erscheinungsformen von Schrift haben durchaus eine längere Tradition, deren Linie sich von der bis in die Antike zurückreichenden visuellen Poesie über die performative Soundpoesie der Avantgarden der frühen 1920er-Jahre bis hin zur Holopoesie in den 1980er-Jahren ziehen lässt.2

Stehen bei diesen Untersuchungen vor allem die verschiedenen Gestaltungsformen von Schrift im Fokus, so entsteht mit dem Computer als Medium noch eine weitere, neue Dimension der Performativität von Sprache. Denn der Computer ist eine ›symbolische Maschine‹, deren verschiedene (für die User:innen unsichtbare) funktionale Schichten mit Programmiersprachen – also sprachlichen Symbolsystemen – gesteuert werden. Deren semantiklose, rein syntaktisch-formale Struktur löst wiederum Prozesse aus, die zu einer sicht- und interpretierbaren Zeichenproduktion auf dem Bildschirm führen. Gerade diese Vielschichtigkeit wird spätestens in den 1980er-Jahren zunehmend zum Faszinosum für das geisteswissenschaftliche Nachdenken über das Wesen und die Dimensionen von Schrift generell und ihrer Medialität3 – sowohl in Bezug auf die Computertechnologien als auch auf deren frühere Materialisierungen: »Schrift und Computer müssen als zwei historische ›Variablenreihen‹ verstanden werden, deren Folgen sich an bestimmten Stellen kreuzen, um neuartige Formen von Schriftlichkeit hervorzubringen, die zugleich auf andere und ältere Glieder beider Reihen zurückverweisen.«4

Beziehen sich die Reflexionen in den 1980er-Jahren zunächst auf die symbolische Verfasstheit des einzelnen Computers, so wird diese in der Frühzeit des World Wide Web durch die Vernetzungsstrukturen nochmals verstärkt thematisiert und neu kontextualisiert, da zu den symbolischen Schichten der Maschine nun auch die Kommunikationsebene der Protokollsprachen hinzutritt, die eine wesentliche Basis der Netzwerktechnologie darstellen:

Der Cyberspace als sozialer Raum, als neue Öffentlichkeit gewinnt seine Eigenart nicht durch die Daten, die in ihm gespeichert sind oder ausgetauscht werden, sondern durch die spezifischen Möglichkeiten und Un-Möglichkeiten der Programmcodes des TCP-IP, der Browser und Chat-Rooms, der Verschlüsselungsprogramme.

Das schreibt Gerfried Stocker in seinem Vorwort zum Katalog des Ars Electronica-Festivals 2003, das sich dem Thema Code – The Language of Our Time widmet.5 Code – in diesem Fall verstanden als Programmiersprache – wird dort als »materia prima unserer modernen, globalen Informationsgesellschaft« bezeichnet, die unsere sozialen, ökonomischen und künstlerischen Handlungsspielräume modelliert und steuert.6 Damit sind Codierungstechniken keine neutralen Tätigkeiten, sondern bestimmen unsere computerbasierten Alltagspraktiken. Ähnlich wie der linguistic turn in den 1960er-Jahren machen sie dadurch darauf aufmerksam, dass unter der Oberfläche unserer Sprache weitere Schichten schlummern, die denk- und handlungsleitend wirken. Demensprechend breit ist auch das Verständnis dessen, was unter den Begriff »Code« fällt – Friedrich Kittlers tour de force durch die Geschichte der Codierungen beginnt daher auch in der Antike mit dem Aufkommen der Alphabetschrift, die, sobald sie mit einer »entfalteten Nachrichtentechnik«7 gekoppelt wird, gemäß Kittler als »Code« bezeichnet werden kann. ›Code‹ ist also strukturell ein endliches Repertoire an Zeichen, das nach festgelegten Regeln zur Übermittlung von Nachrichten eingesetzt wird. Diese Bestimmung erfolgt zunächst medienunabhängig und umfasst die militärische Nachrichtenübermittlung genauso wie die juristische Codierung von Handlungsanweisungen im gesetzgebenden »Codex«, wird aber ebenfalls für die moderne Telekommunikation vom Morsecode bis zur Computerprogrammierung verwendet.8

Kurz vor dem Erscheinen des Ars Electronica-Katalogs Code – The Language of Our Time prägt Alan Sondheim den Begriff »codework«.9 Dieser bezieht sich zunächst ganz generell auf die Arbeit mit sprachlichen Symbolen, wird aber insbesondere auf Phänomene angewandt, die – inhärent selbstreflexiv – die Programmiersprachen zum Kern ihrer performativen Sprachkunstwerke machen. Derartige »code-poetry«10 ist für Sondheim der Ausgangspunkt, um das Programmieren als Kulturtechnik in den Fokus zu rücken. Seine Beschreibung von codework bezieht sich in erster Linie auf Literatur bzw. Poesie, die mit Programmiersprachen arbeitet, ohne dass die Texte notwendigerweise ausführbare Software sein müssen. Eine inzwischen schon fast kanonisch zu nennende Protagonistin solcher code poetry ist die Australierin Mary Ann Breeze, genannt mez, die mit der Kombination von ›normaler‹ Sprache und Programmierelementen seit Ende der 1990er-Jahre ein umfangreiches poetisches Werk kreiert.11 Sie nennt ihre spezifische Sprachmelange »mezangelle«, eine »digital creole«12, die, ähnlich wie die Programmiersprachen, in gewisser Weise auch erlernt werden muss. Diese Sperrigkeit erinnert – vielleicht zufällig, vielleicht aber auch, weil strukturell tatsächlich vergleichbar – an die Plansprachen des 18. und 19. Jahrhunderts: Volapük oder das bekanntere, heute noch praktizierte Esperanto wurden als Weltsprachen konzipiert, deren Elemente so beschaffen sind, dass sie für alle, gleich aus welcher Kultur, gut erlernbar sein sollen. Alle diese Sprachen haben auch poetische Dimensionen, so gibt es bis heute eine spezifische Literaturszene in Esperanto. 13 Code und codework sind also Begriffe, die in der kulturtheoretischen Reflexion um die Bedeutung von Computer, Internet und World Wide Web, wie sie sich um 2000 auf einem ersten Höhepunkt bewegt und nach und nach verschiedene geisteswissenschaftlichen Disziplinen erfasst, eine wichtige Rolle spielen. Sie werden einerseits im Hinblick auf die Funktionserweiterungen von Sprache und Schrift generell diskutiert, andererseits aber auch als ästhetisch-literarisch-poetisches Phänomen zunehmend ernst genommen. In der Praxis bedeutet das, dass sich das, was man unter codework verstehen kann, zunehmend ausweitet und ausdifferenziert, weil der Begriff zwangsläufig mit der Entwicklung der Computertechnologie engstens verflochten ist. So erhält er im Verlauf der Jahre weitere Bedeutungsdimensionen, die ich im Folgenden skizzieren möchte. Dabei vertrete ich die These, dass der Begriff codework in erster Linie Strategien der medialen Selbstreflexion mittels sprachähnlicher Symbolsysteme bezeichnet, die darauf abzielen, die – prinzipiell klandestine – Funktionsweise von Computer und Computernetzwerken transparenter werden zu lassen. Dadurch verschwimmen die Grenzen zwischen Kunst und Aktivismus – mit der Folge, dass es keine (kunsttypische) Trennung mehr zwischen aktiven Produzierenden und passiv Rezipierenden gibt, da alle Beteiligten zu Akteur:innen werden.

Codework und Softwarekunst: Die frühen 2000er-Jahre

In den frühen 2000er-Jahren wurde der von Sondheim lancierte Begriff des codework intensiv innerhalb der literarischen Szene der Praktiker:innen und Theoretiker:innen diskutiert – primär in seiner Erscheinungsform als code poetry, aber auch im Rahmen der Genreüberlegungen, die sich in und um net.art, Netzkunst, net.literature, Netzliteratur, elektronische Literatur etc. entspinnen. Florian Cramer gibt in seinem Text »Zehn Thesen über Softwarekunst« von 2003 einen Einblick in die verschiedenen kursierenden Begrifflichkeiten und analysiert die jeweiligen, mit diesen verbundenen Prämissen. Ganz generell versteht er unter »Softwarekunst« jegliche Kunstformen, deren Basis eine Software bzw. eine algorithmische Struktur bildet. Mit Bezug auf Philip Galanter verweist er auf den Begriff der »generativen Kunst«, die Algorithmen zum Zentrum ihrer Existenz erklärt. Damit, so Cramer, schließt sie an Grundsätze der Autonomieästhetik an, denn sie propagiert einen »autonomen Ablauf« der Programme und läuft daher Gefahr, in einem »Programmiergeniekult« zu gipfeln.14 Dem hält Cramer die damals aktuellen künstlerischen Subversionsprojekte der sog. Browserkunst entgegen, die mit dysfunktionalen Programmen die korrekte Anzeige von Webseiten dekonstruieren. Tatsächlich beschäftigen sich um die Jahrtausendwende zahlreiche net.art-Projekte mit der Arbitrarität der Regeln für die Anzeige von Webseiten. Da die große Leistung von Tim Berners-Lees Entwicklung der Seitenbeschreibungssprache HTML in der Plattformunabhängigkeit besteht, wird nun Software benötigt, die die Dokumente gemäß der HTML-Beschreibungen korrekt darstellt – also Text in die entsprechenden Visualisierungen übersetzt. Das leisten Browser, die allerdings auch so programmiert werden können, dass sie die HTML-Codes anders als eigentlich beabsichtigt darstellen. Die diesem Verhältnis von Seitenbeschreibungssprache und programmbasierter ›Auslegung‹ zugrundeliegende Willkür wird relativ bald zum Gegenstand von verschiedenen netzkünstlerischen Projekten.

Schon 1995 – also weniger als zwei Jahre nach der Einführung des WWW – stellt das Künstler:innen-Duo Jodi (Joan Heemskerk und Dirk Paesmans) mit %Location ein browserkritisches Projekt vor.15 Geht man auf die URL ›wwwwwwwww.jodi.org‹, so wird einem zunächst eine klassische textbasierte Bildschirmoberfläche angezeigt: grüne Schrift auf schwarzem Grund. Zeilenweise reihen sich hier kryptische, sinnfreie ASCII-Zeichenreihen aneinander – kein Klicken, kein Scrollen bringt Sinn in dieses Wirrwarr, der Klick auf die (Schein)Links erzeugt nur weitere kryptische Anzeigen.

Aber: Wenn der:die User:in die (damals relativ neue) Browserfunktion der Quellcode-Anzeige nutzt, kommt plötzlich Ordnung ins Chaos, weil sich Zeichnungen aus ASCII-Code zeigen, die an Architekturskizzen oder Querschnitte von Instrumenten erinnern, allerdings ohne eindeutig identifizierbar und zu konkreten Objekten zuordenbar zu sein. Der Gegensatz zwischen chaotischer Oberfläche und geordneter Tiefenstruktur ist jedoch offensichtlich.

Sechs Jahre später wird Jodi mit dem Projekt %Wrong Browser (2001) noch radikaler. Dieser erzeugt psychodelisch-neonfarbene abstrakte Formen und übereinander geschichtete, nicht entzifferbare Textlayer, bei denen nicht zwischen angezeigtem Text und Softwarecode unterschieden wird:16 »Instead of text, images and standard interface elements, I am thrown into a random universe of dazzling code lines«, schreibt Sonia Fizek über ihren Selbstversuch mit %Wrong Browser 21 Jahre später.17

Wie das Vorgängerprojekt Jodi Oss, das den gesamten Bildschirm der User:innen mit einem wilden Tanz schwarzer unkontrollierbarer Browserfenster füllt, fordert auch dieses Projekt das Konzept der Interaktivität heraus, das bis heute als eines der wesentlichsten Kennzeichen des Netzes gilt. Keines der Projekte reagiert auf Eingaben und Steuerungsversuche, weshalb sie einzig durch die Resignation der Benutzer:innen ihren spielerischen Charakter entfalten können: »Having initially attempted to understand the undecipherable set of visual operations, I ended up simply appreciating the visual confusion. The truth lies in the beauty of the digital performance«,18 lautet dementsprechend Fizeks Fazit. Daher wird %Wrong Browser auch zur Kunst erklärt, oder, wie Fizek es nennt, zum »Meta-Game«, weil das Projekt offenbart, dass eine befriedigende Form der Interaktivität für die User:innen untrennbar mit Kontrolle und Steuerbarkeit verbunden ist: Man vollzieht eine Handlung und weiß (meistens), wohin sie führt, weil man die Regeln und die Befehle kennt – ein Grundprinzip, auf dem die meisten gängigen Videospiele aufbauen. Indem Jodi diese Kausalbeziehung bewusst demontiert, verweist das Künstler:innen-Duo auf die Arbitrarität von Software und die nur scheinbar vorhandene Kontrollierbarkeit durch die nicht-computerliteraten Anwender:innen.19 Hinzu kommt, dass %Wrong Browser weltweit .com-Domains ansteuert und damit auf die zunehmende Kapitalisierung des Netzes aufmerksam macht. Die in der Frühzeit des WWW gefeierte offene Wissensvermittlung und basisdemokratische Teilhabe ist – das wird gerade um 2000 herum heiß diskutiert – durch verschiedene Kommerzialisierungsvorhaben (von proprietärer Software bis zur Vergabe von Domain-Namen) in Gefahr. Damals, lange vor dem Aufkommen der social media-Plattformen, war dies ein weitreichendes Drohszenario, das großes aktivistisches Potential freisetzte. John Perry Barlows Manifest »Declaration of Independence of Cyberspace« von 1996,20 mit dem er gegen die kommerziellen Regelungsversuche des gerade vom US-Senat verabschiedeten »Telecommunications Reform Act« protestiert und das WWW zum kapitalismusfreien Raum erklärt, ist bis heute eines der markantesten Dokumente hierfür. Tatsächlich werden in dieser Zeit zahlreiche Verbünde gegründet, die die Freiheit des Cyberspace vor kommerziellem ›Missbrauch‹ verteidigen und hierzu subversive Strategien entwickeln, welche sich bewusst der symbolischen Ebenen des Computers bedienen. Der Chaos Computer Club, die Electronic Frontier Foundation, etoy, knowbotic research (heute: knowbotiq) – all diese Gruppen treibt die Verteidigung der Freiheit des Netzes um. Besonders deutlich wird dies im sogenannten TOYWAR, der 1999/2000 von der Kunstaktivist:innen-Gruppe etoy.com gegen den Online-Spielzeugvertreiber Etoy Inc. geführt wurde, als letztere erstere wegen Verletzung des Markenrechts verklagen wollten. Eine besondere Form des »Information War« wird entfacht, auf dessen aktivistischem Höhepunkt das Verkaufsportal der Etoy Inc. mehrere Tage lang lahmgelegt wird, so dass dem Unternehmen Schäden in Millionenhöhe entstehen, die wiederum den Aktienkurs absacken lassen – ein Einbruch, von dem sich Etoy Inc. nicht mehr erholen wird. Dieser Krieg wird tatsächlich primär auf den verschiedenen vorhandenen Code-Ebenen geführt und bedient sich Hackerstrategien – »Hacktivism« wird eines der vielen Schlagwörter, die seitdem derart subversive, aber nicht notwendigerweise kriminelle Codepraktiken bezeichnen.21

Auch wenn sich die eben genannten Beispiele aus der Browserkunst und dem künstlerisch inszenierten Netzaktivismus auf die Frühzeit des World Wide Web beziehen, deren technische Basis sich bis heute in vielerlei Hinsicht verändert hat, so verweisen sie dennoch auf ein nach wie vor gültiges ambivalentes Spannungsfeld, das die Computertechnologien von Beginn der modernen Computerentwicklung in den 1940er-Jahren an bis zur aktuellen Diskussion um die Künstliche Intelligenz begleitet: Der Absicht, den User:innen maximale Steuerung und Kontrolle der Technologien zu ermöglichen, steht das Streben, der Technologie größtmögliche Autonomie zu verleihen, gegenüber. Diese Ambivalenz ist ein Grundmotiv kybernetischen Denkens – nicht umsonst trägt deren Gründungsdokument, Norbert Wieners 1948 erschienenes Werk Cybernetics, sowohl die Kontrolle als auch die Kommunikation in ihrem Titel.22

Vor diesem Hintergrund bestätigt sich, dass der Begriff des codework alle selbstreflexiven Praktiken mittels computerspezifischen Codes umfasst und deutlich über den primär ästhetisch verstandenen Bereich der code poetry hinausgeht. Dies gilt nicht nur, weil zahlreiche Ansätze von softwarebasierter Kunst im Sinne Florian Cramers die Perspektive auf das Programmieren und auf die Eigenlogik maschineller Vernetzungsprozesse legen, sondern auch, weil die Rolle der User:innen als interagierende Personen mitgedacht wird. Softwarekunst und Hacktivism können ohne die Aktivität der ›Endbenutzer:innen‹ nicht funktionieren, die damit zum inhärenten Bestandteil der Projekte werden. Nicht nur ist Softwarekunst als spezifische Kunstform des Computerzeitalters zu verstehen, weil sie sich selbstreflexiv mit den Eigenschaften computerbasierter Zeichensysteme und deren Handlungsräumen beschäftigt, sondern sie legt die denk- und handlungsleitenden Funktionen von Software offen. Programmieren formt, wie das Sprechen und Schreiben in natürlicher Sprache, die Welt und ist daher auch eine politische Tätigkeit – eine Erkenntnis, die durch die zunehmende Bedeutung der vernetzten Plattformen im WWW umso mehr Brisanz erhält. Unter diesen Voraussetzungen rücken Praktiken zunehmend in den Mittelpunkt, mit denen systeminterne Mechanismen der Vernetzung kritisch hinterfragt werden.

Hacking: Die ästhetischen Dimensionen eines systeminternen Aktivismus

Die Schnittstelle zwischen Kunst und Aktivismus, die durch TOYWAR erstmals für eine größere Netzgemeinschaft manifest wird, lässt die kulturtheoretischen und soziopraktischen Dimensionen der Arbeit mit Codes unübersehbar werden. Diese Erkenntnis rückt eine Gruppe von Computerliterat:innen in den Mittelpunkt, die bis dato eine höchst ambivalente Stellung in der Informationsgesellschaft innehatten: die Hacker:innen.

Wie Annika Richterich und Karin Wenz in ihrer Einleitung zum Sonderheft über »Hacking and Making« des Journal for Digital Culture & Society ausführen, oszilliert die Selbstdefinition der Hacker-Community schon immer zwischen Subversion von kapitalistischen Machtstrukturen einerseits und Kampf für die Freiheit der Information andererseits: »A key aspect of the hacker ethic is that information should be free from restrictions such as ownership or monetary aims. This call for complete access challenges authorities as it asks for free flow of information through a system of transparency.«23 Dieser Grundsatz wird verbunden mit einem hohen Anspruch an die eigenen technischen Fähigkeiten, die es möglich machen, über die Beherrschung der Computercodes Hacking-Aktionen durchzuführen, die Sicherheitslücken in komplexen Computersystemen aufdecken – eine inzwischen von vielen Firmen und Organisationen gesuchte Kompetenz. Die Hacker:innen-Communities verfolgen daher auch bestimmte qualitative Grundsätze, die »a good hack« auszeichnen, von denen die ersten beiden sich durchaus mit den Grundsätzen »guten Programmierens« decken: »(1) the tenet of simplicity (these activities must be straightforward, yet also be equally outstanding); (2) mastery (all acts, no matter their simplistic attributes, must emanate from an advanced form of technical proficiency); (3) their ›illicit‹ quality (these acts must oppose some form of legal or institutional regulations)«24. Diese Fähigkeiten führen zu einer neuen Form der literaten Kulturtechniken, die Annika Richterich mit Kavita Philip als »technological authorship« bezeichnet, ein Begriff, der sich auf »techno-creative practices and their producers« bezieht. »Technological authorship […] describes social practices and products/results emerging in interaction with technology. These results may be new digital objects, such as software or hardware, or modifications of existing technology.«25 Damit weist die Praxis des Hacking deutlich über codework und Softwarekunst als sprach- bzw. zeichen- und symbolbasierte Tätigkeit hinaus – es geht nicht nur um Programmierung, sondern um Technikmanipulation, die auch Hardware betrifft. Die Grenze zur Do-It-Yourself-Kultur (DIY) und zu dem, was als »FabLabs« oder »Makerspaces« (genauso wie übrigens die an Universitäten und Fachhochschulen inzwischen etablierten eventähnlich strukturierten »Hackathons«) inzwischen recht weit verbreitet ist, ist daher fließend, wie Richterich und Wenz in ihrer Einführung hervorheben.26 Dennoch bleibt die Klientel für solche Grassroot-Initiativen begrenzt – die technophilen Bastler:innen und Tüftler:innen bilden jeweils eigene, teils auch nur temporär existierende Communities mit sehr spezifischer Ausrichtung.27

Inzwischen hat der Begriff des »Hacking« in vielen verschiedenen Bereichen Einzug gehalten – »Biohacking«, »Urban Hacking«, »Life Hacking« sind Begriffe, die auf kreative Umdeutungen bestehender Technologien und Praktiken verweisen und die auf die ein oder andere Weise – wieder – die Grenzen zur Kunst überschreiten. Dass dieses Verhältnis von Subversion und Kunst im Sinne einer Umdeutung etablierter Praktiken der Wahrnehmung, des Verhaltens und des Umgangs mit technischen Artefakten in bestimmten Umgebungen/Kontexten schon sehr viel älter ist als die digitalen Medien, lässt sich gut an den Avantgarde-Aktionen der 1960er-Jahre demonstrieren, die sehr oft gleichzeitig eine Kritik und eine Umdeutung der Mediennutzung implizieren. In ihrem historischen Blick auf künstlerische Praktiken des »Urban Hacking« argumentiert Angela Krewani, »that media interventions into public spaces display a long, democratic genealogy and are closely linked to the democratic use of spaces and media. These media interventions justify the understanding of urban hacking as a combined spatial and mediated practice, which nowadays particularly revolves around locative media.«28 Diese These untermauert sie mit Rekurs auf Fluxus-Aktionen wie Valie EXPORTS Tapp- und Tast-Kino von 1968, das sie als Verbindung von »urban activism with a critique of the cinematic viewing situation« liest, da im städtischen Raum eine Kinosituation (blindes Tasten in einem Kasten vor Valie EXPORTS nackten Brüsten) simuliert wird, die auf die beständige Exposition weiblicher Körper für den männlichen Blick im Hollywoodkino verweist. Der Schwerpunkt von Krewanis Beispielen liegt jedoch auf Medienpraktiken und deren subversiver Umdeutung zu demokratischen Instrumenten – dies gilt insbesondere für Video- und TV-Projekte wie Guerilla Television von Michael Shamberg (1971), einem Handbuch für alternative (und interaktive) Nutzung des Fernsehens, oder die Diskurse in der 1970 neu gegründeten Zeitschrift radical software mit ihren zahlreichen Konzepten und Vorschlägen für eine alternative, demokratische Umdeutung der (Massen)Mediennutzung und Anleitungen für den Bau entsprechender Geräte und Infrastrukturen (ganz analog zur heutigen DIY-Kultur).29 Auf diese Weise entstehen »hybrid spaces«, die Eric Kluitenberg als Verflechtung lokaler (eben auch physisch-sozial vorhandener) Netzwerke mit international-virtuellen Netzwerken mittels legaler oder illegaler Nutzung von Kommunikationstechnologien versteht. Ihre Akteur:innen greifen mit subversiven Medienstrategien in reale Räume ein, indem sie deren Konstruktionsmechanismen und Funktionsweisen hinterfragen, z. B. als »tactical cartography« die Vermessung und Visualisierung von Räumen neu und anders denken oder mittels Strategien der »disconnectivity« die absichtliche Ausschaltung bzw. Abkopplung von technobasierter Kommunikation (und damit auch z. B. von Überwachung) verfolgen.30 Diese Strategien greifen wiederum auf symbolische, sprach- und zeichenbasierte Darstellungs- und Handlungsformen zurück – sei es, dass sie kartographische Abstraktionen neu interpretieren, sei es, dass sie Verbindungen technischer Signalübertragung kappen oder umleiten. Auch die von Krewani angeführten Beispiele von ›Protohacking‹-Praktiken der künstlerischen Avantgarde sind sprach- und codebasiert, allerdings immer im Zusammenhang mit konkreten technischen Artefakten und technologisch-räumlichen Ensembles zu denken.

Die Brisanz und Wirksamkeit von Hackingpraktiken und deren künstlerischer Pendants liegen in der Überführung sprach- und symbolbasierter Praktiken in physisch-materiell-räumliche Konstellationen, wie Krewani auch am Beispiel des Projekts Uncle Roy All Around You (2003) des Künstlerkollektivs Blast Theory demonstriert. Dieses »pervasive game«31 besteht aus einem komplexen medialen Ensemble von realem Stadtraum, digitalen Tracking- und Kommunikationstechnologien sowie menschlichen Akteur:innen, die in einer Mischung von Rollenspiel und Schnitzeljagd eine fiktive Gestalt, Uncle Roy, in einem realen Raum aufspüren müssen.32

Diese Verbindung von Raum und neu gedachten/kontextualisierten/ver-rückten medialen Strukturen erweitert das Verständnis von codework nun um außersprachliche Dimensionen, durch die eingeübte Wahrnehmungs- und Handlungsmuster umfassend hinterfragt werden. Geht man davon aus, dass es immer schon eine wichtige Aufgabe der Kunst war, standardisiertes Verhalten herauszufordern und umzudeuten, liegt es durchaus nahe, Hacking-Praktiken mit ihren systemischen Selbstreflexionen als künstlerische Strategie zu denken – denn wo, außer in der Kunst, wird radikaler über die Infragestellung von Selbstverständlichem, Standardisiertem nachgedacht? Kunst und Subversion scheinen damit inhärent aufeinander bezogen zu sein, was auch zur Folge hat, dass es in diesen Kontexten keine passive Rezipient:innenrolle mehr gibt: Überall, wo Kunst zu Aktivismus wird (oder vice versa) werden die klassischen Grenzen zwischen Kunstwerk bzw. -projekt und Rezipierenden aufgehoben – im ästhetischen Aktivismus (oder in der aktivistischen Ästhetik) sind alle Beteiligten auch Akteur:innen.33 Damit werden neue Perspektiven und Erweiterungen des Begriffs codework über die poetologische Bedeutung hinaus eröffnet, die aufzeigen, wie substantiell die epistemologischen und sozialen Dimensionen des derzeitigen medialen Wandels sind.

KI, Code und Kunst: Auf dem Weg zu einer neuen Dimension des codework?

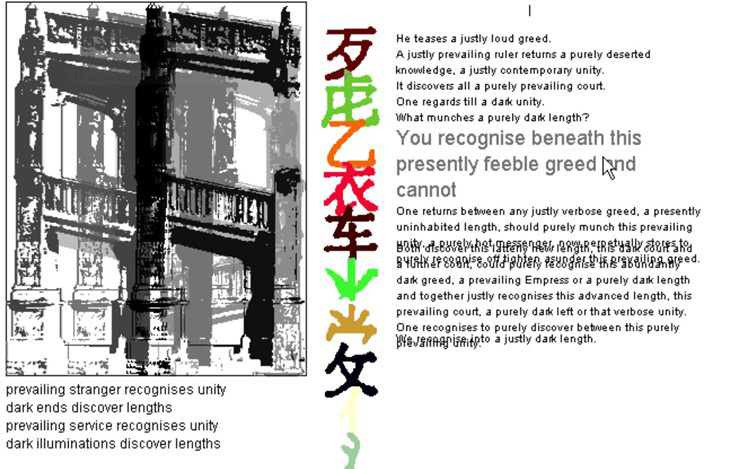

Dieser Eindruck wird noch verstärkt durch die aktuelle Aufregung über das, was gemeinhin als »künstliche Intelligenz« bezeichnet wird: Tatsächlich könnte angesichts von ChatGPT und anderen derartigen Anwendungen eine neue Epoche des codework im weitesten Sinne ausgerufen werden, in der die Willkür der Maschinen eine bisher nie dagewesene, den Menschen existentiell berührende Dimension erreicht. Deep Learning-Technologien und Künstliche Neuronale Netzwerke führen zu einer neuen Selbstreferentialität der Codeerzeugung, die nicht mehr zu vergleichen ist mit den frühen Formen der Textgenerierung, wie sie in den Experimenten der Stuttgarter Schule mit ihren »stochastischen Texten« (Theo Lutz) oder der ersten computergenerierten Lyrik, die aus Wortmaterial menschlich verfasster Gedichte neue syntaktisch korrekte, aber zufallsbasierte Kombinationen herstellte, praktiziert wurde.34 Auch strukturell ähnliche, Ende der 1990er-/Anfang der 2000er-Jahre entstehende computer- oder netzliterarisch/-künstlerische Projekte referieren auf die Prinzipien zufallsgenerierter Kombinationen, deren Datenbasis aber vorab quantitativ und qualitativ festgelegt und mit vergleichsweise überschaubarem, vor allem aber vom Menschen ausgewählten Material versehen wird. Zu denken ist hier beispielsweise an Simon Biggs‘ nach wie vor ästhetisch beeindruckendes Projekt The Great Wall of China (1999), in dem er aus dem Wortmaterial von Franz Kafkas Erzählung »Beim Bau der Chinesischen Mauer« ein intermediales Ensemble erstellt, das auf Mausklick das Wortmaterial ständig neu sortiert und so unendlich viele Variationen der Erzählung erzeugt.35 Gekoppelt ist der Text mit chinesischen Schriftzeichen und einer architektonischen Zeichnung, bestehend aus verschiedenen beweglichen Elementen. Jedes dieser Module reagiert auf die Interaktionen mit den User:Innen; außerdem sind alle (nach verborgen bleibenden Regeln) miteinander gekoppelt. Die Rezeption dieses performativen intermedialen Ensembles ist nicht so sehr durch klassisches Lesen der beständig neu sich formierenden Texte geprägt, sondern durch ein spielerisches Erkunden der programmbasierten Interdependenzen, auch wenn die eigentlichen Steuerungsmechanismen intransparent bleiben.

Doch welche neuen Fragen stellen sich nun angesichts von KI-Programmen wie ChatGPT, GPT 4, Dall-E und Midjourney? Folgt man den Diskussionen in den Feuilletons, dann bekommt man den Eindruck, dass vor allem Themen wieder aufgegriffen werden, die letztlich Altbekanntes verhandeln. Beispielsweise nimmt die Frage nach der Autorschaft und der Rollenverteilung zwischen den beteiligten menschlichen und technischen Akteur:innen großen Raum ein. Aufgebaut wird ein Szenario, bei dem sich Mensch und Maschine als Kontrahenten gegenüberstehen. Diese Polarisierungstendenzen führen dazu, dass den KI-Programmen weitgehend unhinterfragt Menschenähnlichkeit unterstellt wird, was die öffentliche Diskussion in zweierlei gegensätzliche diskursive Richtungen führt: In der einen werden fleißig Beispiele generiert und gesammelt, in denen den KI-gesteuerten Programme wie ChatGPT oder GPT 4 Fehler nachgewiesen werden können, seien sie sprachlicher oder faktischer Natur. Daniel Kehlmann führt dies beispielsweise in seinem Büchlein Mein Algorithmus und ich. Stuttgarter Zukunftsrede von 2021 paradigmatisch vor, wenn er mit dem Textgenerierungs-Programm »CTRL« interagiert, um gemeinsam mit diesem eine Erzählung zu schreiben, zum Schluss aber geradezu triumphierend feststellt, das Programm habe eben doch kein Bewusstsein und müsse daher scheitern.36 Die andere Richtung imaginiert und dämonisiert eine KI, die den Menschen über kurz oder lang überlegen sein wird und ihn daher womöglich entmachten könnte. Die kultur- und medientheoretisch informierten Diskurse bemühen sich dagegen schon seit einiger Zeit um eine sachliche Abwägung der Verhältnisse, wie zahlreiche Untersuchungen der letzten Jahre belegen.37

Die Beunruhigung durch die aktuellen Entwicklungen wird dadurch allerdings nicht unbedingt aufgehoben; dazu sind die technologischen Unwägbarkeiten zu groß. Wurde schon in den frühen 2000er-Jahren die Forderung nach einer neuen Disziplin der »Software Studies« und mit diesen der »Critical Code Studies« laut,38 deren Protagonist:innen eine »critical hermeneutics to the interpretation of computer code, program architecture, and documentation within a socio-historical context«39 forderten, so geht es mittlerweile um eminent ethische Fragen. Neue Richtungen wie die »Explainable AI« als Subdisziplin der Informatik reagieren auf die Ignoranz selbstlernender Systeme bezüglich rassistischer und/oder sexistischer Tendenzen, die darauf zurückzuführen ist, dass keines der derzeit die öffentliche Diskussion bestimmenden Programme in der Lage ist, im menschlichen Sinne zu verstehen, geschweige denn zu erkennen, wenn ethisch bedenkliche Ungleichheiten bei der Mustererkennung, wie sie sich im racial oder gender bias von Gesichtserkennungs-Software und in diskriminierenden Äußerungen selbstlernender Chatbots manifestieren, überhand nehmen.

All diese Problematiken rufen einen weitgehend neuen Typus von codework auf den Plan, der – ähnlich wie manche Hacking-Projekte – die Grenze zwischen Programmierpraxis und Kunst verschwimmen lässt: Das Digital Nutrition Project (seit 2018) beispielsweise wurde von einem US-amerikanischen Programmier:innen-Team40 entwickelt mit dem Ziel, die Datensets analysierbar zu machen, die KI- und Machine Learning-Systeme benutzen, um ihre Funktionalität zu verbessern.41 Diese werden auf implizite (rassistische, sexistische und weitere) Schwerpunktsetzungen hin analysiert und nach entsprechenden Imbalancen durchsucht. Analog zu den Nährwertanalysen auf Lebensmitteln bekommen sie schließlich ein ›Label‹ verliehen, das Aussagen über den Grad der blinden Flecken der Daten trifft. Das Data Nutrition Project erzeugt somit keine ausstellbaren Ergebnisse, aber als ein interdisziplinäres Netzwerk von Expert:innen erhebt es den Anspruch, eine Beratungsinstanz für alle Bereiche zu sein, in denen große Datenmengen ausgewertet werden – bis hin zur pädagogischen und politischen Arbeit, mit der sie auf diese Probleme aufmerksam machen wollen. Damit entsteht eine Art Hacking, das sich nicht mehr gegen etwaige Menschen hinter den Programmen richtet, sondern gegen die maschinellen Logiken. Das Aufklärerische, das den Projekten Jodis noch innewohnte, das Umdeuten und Verfremden von menschengemachten Programmstrukturen, wie es die Hacker praktizieren, muss nun offensichtlich auf maschinelle Logiken ausgerichtet werden, die nicht mehr rein durch die Kenntnis von entsprechenden Codes zu beherrschen sind.

Diese Erkenntnis haben sich Tiga Brain und Sam Levigne mit dem Synthetic Messenger zueigen gemacht. Dieses ebenfalls auf der Ars Electronica 2022 präsentierte Projekt greift in normalerweise rein maschinell ablaufende Prozesse ein, um deren Eigendynamik für bestimmte Zwecke umzuprogrammieren. In diesem Fall betrifft das Bots, die normalerweise durch automatisierte Zugriffe Klickzahlen für Webseiten generieren. Die Initiator:innen haben sie nun daraufhin programmiert, das Netz nach Nachrichten über den Klimawandel zu durchsuchen und in diesen die Anzeigen anzuklicken. Damit wollen sie die Gewichtigkeit der Nachrichten verschieben, indem sie die inzwischen automatisierte Aufmerksamkeitsökonomie des Netzes umdeuten:

Synthetic Messenger ist ein Botnetz, das den Wert von Klimanachrichten künstlich aufbläht. Jeden Tag durchsucht es das Internet nach Nachrichtenartikeln über den Klimawandel, dann besuchen 100 Bots jeden Artikel und klicken auf jede Anzeige, die sie finden können. In einer von Algorithmen geprägten Medienlandschaft wird der Wert von Nachrichten durch Aufrufstatistiken bestimmt. Die Medien sind auf Werbeeinnahmen angewiesen, die durch Seitenaufrufe und Anzeigenklicks erzielt werden und diese Interaktionssignale führen zu Wertmustern, die beeinflussen über welche Geschichten und Themen in Zukunft berichtet wird. Die öffentliche Berichterstattung über den Klimawandel wird durch diese miteinander verwobenen algorithmischen und wirtschaftlichen Logiken geprägt – Logiken, die derzeit von der fossilen Brennstoffindustrie genutzt werden. Der Synthetic Messenger ist ein klimatechnischer Plan zur Manipulation der algorithmischen Systeme, die diese Narrative formen. Was wäre, wenn man die Medien selbst als eine Form des Climate Engineering betrachten würde, als einen Raum, in dem Narrative zu Ökologie werden?42

In den Fokus rückt bei diesem Projekt nun die Logik des Internets, dessen Informationspolitik durch quantitative, teilweise automatisch generierte Klickgesten gesteuert wird. Es macht dabei in erster Linie deutlich, wie manipulativ die algorithmisierten Aufmerksamkeitsstrategien im WWW sind und wie wenig wir diese ohne entsprechende Kenntnisse beeinflussen können. Da der Kern des Projekts im Umfunktionieren von Bots liegt, schließt es damit an Hacking-Strategien an und betont einmal mehr, wie wichtig die genuin künstlerische Reflexion aller Standardisierungsprozesse tatsächlich ist.

Fazit

Die Arbeit mit KI-Programmen fügt dem Begriff des codework eine weitere Dimension hinzu. Als Begriff, der bisher technokritisch-selbstreflexive Praktiken kennzeichnete, die in wechselnden medialen Konstellationen stattfinden und unterschiedliche sprachliche Verfasstheiten adressieren, in denen allerdings immer der Mensch die Steuerungshoheit hat, wird er nun zur »Cyborg-Autorschaft« hin erweitert.43 Ist diese im Bereich der elektronischen Literatur primär ästhetisch konnotiert, so wird angesichts der aktuellen Arbeit mit KI-Programmen immer deutlicher, dass die Koevolution zwischen Mensch und Maschine womöglich nun in eine neue Phase eingetreten ist. Wenn der Begründer der Critical Code Studies, Mark C. Marino, ein wenig ironisch, aber dennoch durchaus ernstgemeint, im Dezember 2022 »The Grand Exhibition of Prompts«44 als Online-Event eröffnet, dann verweist er auf einen wichtigen Aspekt für die zukünftige Ausgestaltung der Mensch-Maschine-Kommunikation: Die richtigen ›Prompts‹ zu formulieren, also die (menschlichen) Spracheingaben, mittels derer den KI-Programmen ihre Aufgaben gestellt werden, ist nämlich alles andere als trivial. Weil der:die Normaluser:in sich in der Illusion wiegt, mit einem menschenähnlichen Gegenüber zu kommunizieren und sich daher wenig Gedanken über seine:ihre Frageformulierungen macht, werden womöglich allzu häufig die falschen Befehle gegeben. Wie hier bestmögliche Kommunikation erzielt werden kann (und welche Kriterien darüber entscheiden, was ›bestmöglich‹ heißt), ist ein Feld, das noch weitgehend unerforscht und mit Sicherheit entwicklungsfähig ist. Ästhetische – und damit auch selbstreflexive – Herangehensweisen können hier sehr hilfreich sein, weil sie nicht dem Zwang einer (wie auch immer gearteten) Vorstellung von Gelingen unterliegen und daher in viele Richtungen denken und experimentieren können, ohne pragmatischen Kriterien (z. B. i. S. der Entwicklung vermarktungsfähiger Produkte) genügen zu müssen.45

Insofern kann davon ausgegangen werden, dass gerade im Grenzbereich zwischen Kunst, Literatur und Programmierung neue, kreative Räume erschlossen werden, mittels derer die Technologien zumindest reflektierbar (wenn schon nicht kontrollierbar) bleiben: Cyborg Authorship als eine weitere, neue Form des codework könnte eine Option hierfür sein, deren Potential jedoch große Herausforderungen birgt, denn sie verlangt von allen Akteur:innen ein hohes Maß an Technologieverständnis.46 Das zu entwickeln wird jedoch ohnehin eine conditio sine qua non sein, wenn es um die Zukunftsgestaltung unserer technosozialen Gesellschaften geht. Mit diesem Projekt ist jede:r gefordert, denn im Zeitalter der globalen Vernetzung und der sozialen Medien agieren wir alle sinnproduzierend und -interpretierend zugleich und sind daher für die Kommunikationsatmosphäre unserer Gesellschaft entsprechend mitverantwortlich.

- 1. Vgl. z. B. Söke Dinkla: Pioniere interaktiver Kunst von 1970 bis heute. Myron Krueger, Jeffrey Shaw, David Rokeby, Lynn Hershman, Grahame Weinbren, Ken Feingold. Ostfildern 1997; Söke Dinkla (Hg.): InterAct! Schlüsselwerke interaktiver Kunst; Ausstellung und Workshops, Wilhelm Lehmbruck Museum Duisburg 27. April bis 15. Juni 1997. Ostfildern 1997; Bernd Scheffer (Hg.): Schrift und Bild in Bewegung. Ausstellungen, Installationen, Performances. München: Gasteig, 27. Mai bis 16. Juni 2000. München 2000; Kai-Uwe Hemken (Hg.): Bilder in Bewegung. Traditionen digitaler Ästhetik. Köln 2000; Peter Gendolla u. a. (Hg.): Formen interaktiver Medienkunst. Geschichte, Tendenzen, Utopien. Frankfurt a. M. 2001.

- 2. Holopoesie nutzt die Technologie des Hologramms, um dreidimensionale ›Textskulpturen‹ zu schaffen, die nur entziffert werden können, indem man sich um sie herum bewegt. Vgl. Friedrich W. Block: »New Media Poetry« (1997). In: Ders.: p0es1s. Rückblick auf die digitale Poesie. Berlin 2015, S. 56–73, hier S. 68–71.

- 3. Vgl. dazu im Überblick Till A. Heilmann: Textverarbeitung. Eine Mediengeschichte des Computers als Schreibmaschine. Bielefeld 2012, S. 25–36. Der Begriff der »symbolischen Maschine« wurde durch Sibylle Krämers Buch Symbolische Maschinen. Die Idee der Formalisierung in geschichtlichem Abriß (Darmstadt 1988) prominent. Sie bezeichnet damit allerdings jegliche Art von (realen analogen und digitalen) Maschinen, die in der Lage sind, aufgrund von Formalisierungen (i. e. symbolerzeugenden Operationen) Aufgaben durchzuführen (vgl. ebd., S. 3).

- 4. Heilmann: Textverarbeitung, S. 6.

- 5. Gerfried Stocker: »Code – The Language of Our Time«. In: Ders. u. Christine Schöpf (Hg.): Code – The Language of Our Time. Katalog des Ars Electronica Festivals 2003. Ostfildern-Ruit 2003, S. 12–14, hier S. 12.

- 6. Ebd. Die sprachbasierte Arbeit mit dem Computer wurde schon in ihrer Frühzeit als »coding« bzw. »Kodierung« bezeichnet, weil sie aus verschiedenen Übersetzungsprozessen besteht. Besonders deutlich wird das an der Vorgängertechnologie des von Neumann-Computers, als die Computerprozesse mittels Lochkarten ausgeführt wurden. Vgl. Heilmann: Textverarbeitung, S. 60–69. Zur Geschichte der protodigitalen Lochkartencodierung vgl. Birgit Schneider: Textiles Prozessieren. Eine Mediengeschichte der Lochkartenweberei. Zürich/Berlin 2007.

- 7. Friedrich Kittler: »Code oder wie sich etwas anders schreiben lässt«. In: Gerfried Stocker u. Christine Schöpf (Hg.): Code – The Language of Our Time. Katalog des Ars Electronica Festivals 2003. Ostfildern-Ruit 2003, S. 15–19, hier S. 15.

- 8. Vgl. ebd., S. 15–19.

- 9. Alan Sondheim (Hg.): Codework. Special Edition of American Book Review 22.6 (September–October 2001).

- 10. Alan Sondheim: »Notes on Codework«, Posting in der Mailingliste nettime vom 10. Februar 2004, https://www.mail-archive.com/nettime-l@bbs.thing.net/msg01653.html (zuletzt eingesehen am 08. Oktober 2023).

- 11. Vgl. auch die Dokumentation auf der Archiv-Webseite NEXT, auf der zahlreiche Werke früher digitaler Literatur zu finden sind, u. a. auch ein Werk von mez: https://collection.eliterature.org/2/works/mez_crossovaing.html (zuletzt eingesehen am 08. Oktober 2023).

- 12. Electronic Literature Organization über mez: »_cross.ova.ing 4rm.blog.2.log 07/08 XXtracts_«, https://the-next.eliterature.org/works/681/0/0/ (zuletzt eingesehen am 08. Oktober 2023).

- 13. Eine faszinierend-poetische Aufarbeitung solcher Versuche unternimmt Clemens J. Setz in seinem Buch Die Bienen und das Unsichtbare (Berlin 2020), in dem sich auch von ihm angefertigte Übersetzungen von Gedichten in Plansprachen finden.

- 14. Florian Cramer: »Zehn Thesen über Softwarekunst«, https://netzliteratur.net/cramer/thesen_softwarekunst.html (zuletzt eingesehen am 08. Oktober 2023).

- 15. wwwwwwwww.jodi.org (zuletzt eingesehen am 08. Oktober 2023). Mein Dank gilt Michael Rottmann, der mich durch seinen Vortrag auf der Tagung der Gesellschaft für Medienwissenschaft am 29. September 2023 wieder an dieses Projekt erinnert hat.

- 16. Diese Experimente sind heute nur teilweise nachvollzieh- und ausführbar, weil sie auf die damaligen Webtechnologien abgestellt waren. Den zahlreichen Experimenten mit alternativen Browsern (darunter auch solche, die durchaus neue Funktionen, wie z. B. die Anzeige von Webseitenstrukturen, bereitstellen) wohnt grundsätzlich eine wichtige visuelle Funktion inne, weil sie die Arbitrarität der Webseitenkonstruktionen thematisieren. Auch im Fall von code poetry kann die Anordnung der programmiersprachlichen Befehlsstrukturen visuelle Qualitäten entwickeln, wie Cramer am Beispiel von Jodis titellosem ›Gedicht‹ über eine Armee und deren Marsch- und Kampfbewegungen demonstriert, deren repetitive Tätigkeiten im einheitlichen Rhythmus in wiederkehrenden, nur geringfügig variierenden Codierungen gespiegelt werden – die Analogie zur konkreten Poesie liegt hier nahe und wird entsprechend herausgearbeitet. Vgl. Florian Cramer: »Wenn Schrift sich selbst ausführt: Über Codes und ihre Reflexion in Literatur und digitalen Künsten«, 2002, https://netzliteratur.net/cramer/schrift_selbst_ausfuehrt.html (zuletzt eingesehen am 8. Oktober 2023).

- 17. Sonia Fizek: »Reading Between the Lines. jodi’s %wrong Browser.co.kr«. In: Inge Hinterwaldner, Daniela Hönigsberg u. Konstantin Mitrokhov (Hg.): Navigation. München 2022, S. 78–89, hier S. 83, DOI: 10.5282/ubm/epub.93518.

- 18. Ebd., S. 86.

- 19. Dies ist allerdings kein neuer Ansatz: Lange vor dem WWW und den subversiven Arbeiten von Jodi arbeitet der Netzkunstpionier Zelko Wiener mit dem damals von der Post lancierten Bildschirmtextsystem BTX, einer rein textbasierten Vorform des WWW. Wie später Jodi entwickelt Wiener auf seiner BTX-Plattform Kunst BTX verschiedene Projekte, die mit der Pixelästhetik der Plattform spielen, aber auch die Intransparenz der zugrundeliegenden Prozesse thematisieren. Auch für ihn ist das Computerspiel eine wichtige Referenz: Mit seinem Projekt Ducks koppelt er ein einfaches Shooting-Game mit fingierten System-Fehlermeldungen. Vgl. Zelko Wiener: Zwischen 0 und 1 im digitalen Umbruch. Ausstellungskatalog, Wienmuseum MUSA, hg. v. Berthold Ecker, Fina Esslinger u. Ursula Hentschläger. Berlin/Boston 2016, S. 379–385. Ich danke Ursula Hentschläger für diesen Hinweis.

- 20. John Perry Barlow: »A Declaration of Independence of Cyberspace«, https://www.eff.org/de/cyberspace-independence (zuletzt eingesehen am 08. Oktober 2023).

- 21. Vgl. dazu den ›Insiderbericht‹ von Reinhold Grether (aka ›agent.nasdaq‹): »How the Etoy Campaign Was Won. An Agent‘s Report«. In: Telepolis, 26. Februar 2000, https://etoy.com/files/press-archive/2000/2000_02_26_telepolis_how_the_etoy_campaign_was_won2.pdf (zuletzt eingesehen am 08. Oktober 2023).

- 22. Der Untertitel des 1948 erschienen Standardwerks von Norbert Wiener lautet: Or Control and Communication in the Animal and the Machine (Cambridge 1948).

- 23. Annika Richterich u. Karin Wenz: »Introduction. Making and Hacking«. In: Digital Culture & Society 3.1 (2017), S. 5–21, hier S. 8.

- 24. Ebd.

- 25. Annika Richterich: »Hacks as Means of Meaning-Making«. In: Christiane Heibach, Angela Krewani u. Irene Schütze (Hg.): Constructions of Media Authorship. Investigating Aesthetic Practices from Early Modern Times to the Digital Age. Berlin/New York 2021, S. 197–214, hier S. 199.

- 26. Vgl. Richterich u. Wenz, S. 10f.

- 27. Vgl. »›There Simply Is No Unified Hacker Movement.‹ Why We Should Consider the Plurality of Hacker and Maker Cultures. Sebastian Kubitschko in Conversation with Annika Richterich and Karin Wenz«. In: Digital Culture & Society 3.1 (2017), S. 185–195, hier S. 187.

- 28. Angela Krewani: »Urban Hacking and its ›Media Origins‹«. In: Digital Culture & Society 3.1 (2017), S. 139–146, hier S. 140.

- 29. Vgl. ebd., S. 141f.

- 30. Eric Kluitenberg: »The Network of Waves. Living and Acting in a Hybrid Space«. In: Open 11 (2006), S. 6–16, hier S. 14f.

- 31. Mit »pervasive game« bezeichnet Blast Theory diese spezifische Mischung aus digitalen Repräsentations- und Kommunikationsformen und der physischen Bewegung der Akteur:innen im realen (städtischen) Raum. Vgl. Martin Flintham u. a.: »Uncle Roy all around you: Mixing Games and Theater on the City Streets«. Proceedings of the 2003 DiGRA International Conference. Utrecht 2003, S. 167–177, hier S. 168, URL: http://www.digra.org/wp-content/uploads/digital-library/05163.14092.pdf (zuletzt eingesehen am 08. Oktober 2023).

- 32. Vgl. Krewani: »Urban Hacking«, S. 144f.

- 33. Diese Dimension kann hier nur angedeutet werden und weist in die derzeit viel diskutierte Richtung von sozial engagierter Kunst und deren Grenzüberschreitungen zwischen geschütztem Kunstraum und gesellschafter Involviertheit. Vgl. exemplarisch dazu: Birgit Eusterschulte, Christian Krüger u. Judith Siegmund (Hg.): Funktionen der Künste. Transformatorische Potentiale künstlerischer Praktiken. Berlin 2020.

- 34. Gemeint sind hier die ersten, syntaktisch sehr simpel gebauten computergenerierten Sätze, die Theo Lutz 1959 erzeugte und »stochastische Texte« nannte (vgl. die von Johannes Auer erstellte Emulation des Generators unter https://auer.netzliteratur.net/0_lutz/lutz_original.html (zuletzt eingesehen am 8. Oktober 2023). Ebenso zählen die ersten Lyrikexperimente dazu, beispielsweise dasjenige von Manfred Krause und Friedeman Schaudt, die 1967 den Großrechner Zuse 23 mit Wortmaterial großer Lyriker wie Johann Wolfgang Goethe, Matthias Claudius, Annette von Droste-Hülshoff und Rabindrath Tagore, aber auch mit juristischen und medizinischen Texten fütterten und ihn Gedichte nach bestimmtem Versmaß und Reimschema generieren ließen. Vgl. Manfred Krause u. Friedemann Schaudt: Computerlyrik. Düsseldorf 1967.

- 35. http://littlepig.org.uk/wall/thewall.htm (zuletzt eingesehen am 08. Oktober 2023). Das Projekt arbeitet flashbasiert und kann daher mit den heutigen Browsern nicht mehr angezeigt werden. Unter https://oldweb.today (zuletzt eingesehen am 08. Oktober 2023) kann man sich alte Browseremulationen laden, mit denen solche Webseiten wieder funktionieren. Ich danke Yvonne Schweizer für diesen Hinweis.

- 36. Vgl. Daniel Kehlmann: Mein Algorithmus und ich. Stuttgarter Zukunftsrede. Stuttgart 2021, S. 44.

- 37. Zu nennen sind hier beispielsweise folgende Publikationen: Mercedes Bunz: Die stille Revolution. Berlin 2012; Lev Manovich: Software Takes Command. New York u. a. 2013; Luciano Floridi: Die 4. Revolution. Wie die Infosphäre unser Leben verändert. Berlin 2015 [2014] sowie seit 2019 die Publikationen der Reihe »KI-Kritik / AI Critique«, die im transcript-Verlag erscheint.

- 38. Vgl. Manovich: Software Takes Command, S. 10–20.

- 39. Mark C. Moreno: »Critical Code Studies«. In: Electronic Book Review, 4. Dezember 2006, https://electronicbookreview.com/essay/critical-code-studies/ (zuletzt eingesehen am 08. Oktober 2023).

- 40. Kasia Chmielinski (US), Sarah Newman (US), Matthew Taylor (US) u. a. Das Projekt erhielt den Preis der Ars Electronica 2022 in der Kategorie ›Digital Humanity‹. Vgl. auch https://datanutrition.org/ (zuletzt eingesehen am 08. Oktober 2023) sowie Gerfried Stocker u. Markus Jandl (Hg.): CyberArts 2022, Linz 2022, S. 152–154, https://ars.electronica.art/planetb/files/2022/08/cyberarts22.pdf (zuletzt eingesehen am 08. Oktober 2023).

- 41. An sich müsste spätestens hier eine kritische Diskussion über die Verwendung des Begriffs ›Künstliche Intelligenz‹ erfolgen. Da es jedoch in jedem Fall sehr aussagekräftig ist, dass Anwendungen wie ChatGPT, Dall-E und Mid Journey als solche bezeichnet werden, weil ihnen selbstlernende Systeme zugrunde liegen, werde ich das als entscheidendes Merkmal aus der öffentlichen Diskussion übernehmen. Es soll jedoch wenigstens darauf verwiesen werden, dass der Begriff ›Künstliche Intelligenz‹ durchaus umstritten ist, und zwar in mehrfacher Hinsicht: Zum einen wird generell in Frage gestellt, ob Maschinen überhaupt jedwede Form menschlicher Intelligenz zugeschrieben werden kann, da sie weit entfernt von Prozessen menschlichen Verstehens sind, zum anderen wird von einigen Wissenschaftler:innen die Meinung vertreten, dass der Begriff der ›Künstlichen Intelligenz‹ völlig anders verstanden werden muss als in Analogie zur menschlichen Intelligenz. Vgl. Bernhard J. Dotzler: »Wer KI mit Menschen vergleicht, missversteht sie«. In: Süddeutsche Zeitung vom 25. Juni 2019.

- 42. Synthetic Messenger, https://ars.electronica.art/planetb/de/synthetic-messenger (zuletzt eingesehen am 08. Oktober 2023), vgl. auch Gerfried Stocker u. Markus Jandl (Hg.): Welcome to Planet B. A Different World is Possible, But How? Ars Electronica Festival 2022, Linz 2022, S. 72, https://ars.electronica.art/planetb/files/2022/08/festival22.pdf (zuletzt eingesehen am 08. Oktober 2023).

- 43. Vgl. auch die Ausführungen von Scott Rettberg: »Cyborg Authorship: Writing with AI – Part 1: The Trouble(s) with ChatGPT«. In: Electronic Book Review, 2. Juli 2023, DOI:10.7273/5sy5-rx37. Auf die verschiedenen künstlerischen Experimente, die sich gerade herausbilden, kann in diesem Rahmen nicht weiter eingegangen werden, zumal es sich um Ansätze handelt, die vor allem die Frage nach dem Verhältnis Text und Bild verhandeln und daher eine andere Richtung als die in diesem Beitrag verfolgen. Vgl. für Kurzskizzen einiger Ansätze aus dem Bereich der Electronic Literature Organization: Scott Rettberg u. a.: »AIwriting: Relations between Image Generation and Digital Writing. Panel presented at ISEA 2023«, Paris 16.–21. Mai 2023, https://arxiv.org/abs/2305.10834 (zuletzt eingesehen am 08. Oktober 2023).

- 44. https://www.youtube.com/watch?v=gQSeOJHPgkM (zuletzt eingesehen am 08. Oktober 2023).

- 45. Dieses Potential zeigen auch die in der Medien- und Literaturwissenschaft derzeit geführten Diskussionen um Künstliche Intelligenz und ästhetische Produktion auf. Vgl. u. a. dazu exemplarisch die Publikationen von Hannes Bajohr, u. a. speziell zur Problematik der Anthropomorphisierung von KI sein Aufsatz »Keine Experimente. Über künstlerische künstliche Intelligenz«. In: Merkur 864 (Mai 2021), S. 32–43; außerdem (weiterhin exemplarisch, also u. a.): Bernhard Dotzler u. Berkan Karpat (Hg.): Götzendämmerung. Kunst und künstliche Intelligenz. Bielefeld 2021 (Reihe KI-Kritik / AI Critique) sowie Stephanie Catani (Hg.): Handbuch Künstliche Intelligenz und die Künste. Berlin/Boston 2024 und das gerade im Entstehen begriffene Routledge Handbook of AI and Literature (hg. v. Will Slocombe u. Genevieve Lively).

- 46. Ein Beispiel hierfür nennt Scott Rettberg in seinem Artikel »Cyborg Authorship«: John Cayleys Projekt The Listeners (seit 2015). Es baut auf Amazons Sprachsystem Echo auf – um es nutzen zu können, braucht man a) ein Echo-System und b) die Kompetenz, mittels der Alexa-App The Listeners zu starten. Wer die Hardware nicht hat, muss einen mühsamen Weg über eine Webseite gehen, auf die er sich mit seinem Amazon-Konto einzuloggen hat (vgl. die Anleitungen auf: http://io.creamcityreview.org/40-2/cayley/, zuletzt eingesehen am 08. Oktober 2023). Dass innerhalb dieser vielen Recherche- und Installationsprozesse wiederum jede Menge Daten anfallen und (u. a. vermutlich von Amazon) gesammelt werden, bleibt weitgehend unerwähnt, obwohl das Projekt in seiner Komplexität ein wunderbares Beispiel für Cyborg Authorship darstellt. Es zeigt allerdings auch die fatalen Abhängigkeiten von externen Anwendungen – so existiert die notwendige Webseite für die Rezeption außerhalb von Echo inzwischen nicht mehr.