Digitales Journal für Philologie

Die Deixis der Literatur

I.1

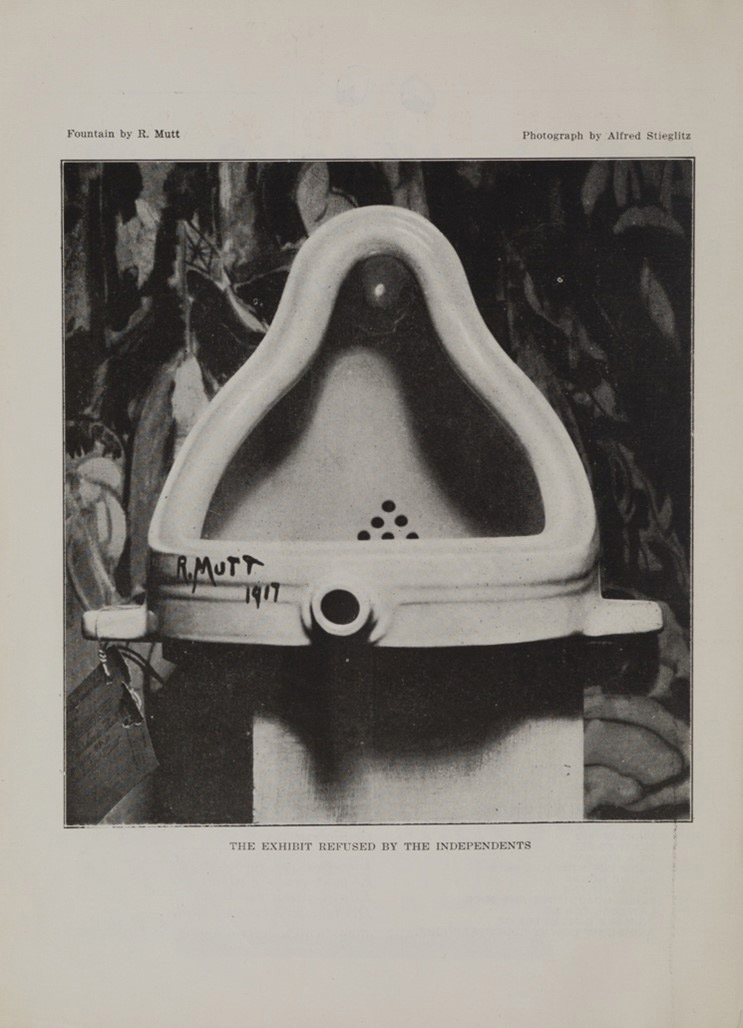

»This is art.« Diese Deixis – das Zeigen auf etwas, im Verbund mit der Erklärung, das Gezeigte sei Kunst – ist die Gründungsgeste der Moderne. Marcel Duchamps Readymade »Fountain« von 1917 ist da das unausweichliche, weil immergültige Beispiel (Abb. 1). Das handelsübliche Urinal, Modell »Bedfordshire«, signiert mit dem Schriftzug »R. Mutt 1917« war nicht das erste Kunstwerk, das diese Geste ausführte (zudem ist Duchamp vorgeworfen worden, die Idee dazu von Elsa von Freytag-Loringhoven gestohlen zu haben)2 – aber in der offensichtlichen Differenz zwischen dem gemeinhin als Kunst und gemeinhin als Nichtkunst Akzeptierten brachte dieses Readymade die Radikalität seiner deiktischen Bedingung so ikonisch wie kein anderes Kunstwerk auf den Punkt. Es besitzt diesen Status nicht zuletzt, weil es die Epoche einerseits als einer von Taylorismus und technischer Reproduzierbarkeit geprägten zeigt, die andererseits über ein ausdifferenziertes, autopoietisches soziales Funktionssystems Kunst verfügt, das »autorlose« Fabrikwaren überhaupt erst für den deiktischen Akt des Zurkunsterklärens hin öffnet.

Jenseits aller historischen Situierung ist diese Deixis aber vor allem deshalb radikal, weil damit die Geste der Rahmung von etwas als Kunst zum ersten Mal zum ausschließlichen Kriterium für Kunst wird. »This is art« ist wie ein Zauberspruch, der ein normales in ein besonderes Ding verwandelt – oder sogar zum Verschwinden bringt. Wie der Kunsthistoriker Thierry de Duve ausführt, wird im Readymade das Objekt hinter der Deixis als kunstkonstitutiver Geste geradezu unsichtbar:

But a readymade shows nothing; it doesn’t even show itself, since it still requires to be shown, designated: this is art. Without the deictic »this«, art has no being. And the readymade doesn’t show anything either, since it is nothing but the statement »this is art«, as it is affixed to any »this« whatsoever.3

Worauf de Duve am Ende seines Buches Kant after Duchamp hinauswill, ist, dass diese Deixis, so willkürlich und subjektiv sie anmuten mag, doch wieder eine Universalität aufruft, nämlich die des kantischen ästhetischen Urteils – nur dass hier statt »das ist schön« eben »das ist Kunst« geurteilt wird:

What remained to be understood in Duchamp’s aftermath, was that »this is art« continues to be an aesthetic judgment in the Kantian sense, not in the sense where it would remain a judgment of taste, however – this is no longer necessarily the case, and certainly not when a readymade is at issue – but in the sense that it requires one to suppose that everybody is endowed with the faculty of aesthetic judgment, defined, after Duchamp, as the capacity of judging, that is, of choosing, that is, of making what deserves to be called art.4

Daher, so de Duve, konnte Beuys – oft genug Kritiker Duchamps – dennoch mit Recht sagen, dass ›jeder Mensch ein Künstler‹ sei.5 Zumindest theoretisch; dass vor der tatsächlichen Anerkennung einer solchen Deixis immer noch Institutionen stehen und Bedingungen des Hör- und Sichtbarmachens,6 ist kein Argument gegen de Duves Interpretation: Was Kunst in der Moderne zu Kunst werden lässt, ist ein Akt der Urteilskraft, dessen normative Macht Bedingung des Werkes ist. Die Konsequenzen aus dieser Situation sind dreierlei.

Erstens ist »this is art« kein bloß konstatierender, sondern ein wirklichkeitsverändernder Sprechakt: Es ist ein Urteil, das von den Urteilenden hinaus in die Welt und in das Objekt wirkt, welches kraft dieses Urteils erst zur Kunst wird. Es ist, anders gesagt, der Fall einer Äußerung, die erst performativ hervorbringt, worauf sie sich intentional bezieht. In dieser Interpretation fallen im Kunstwerk der Moderne Noema und Noesis – Gegenstand und Art des Gegebenseins – derart zusammen, dass alle anderen Eigenschaften, die das Objekt sonst noch auszumachen mögen – seien sie materiell oder in einem anderen Sinne »ästhetisch« –, irrelevant sind. In äußerster Verdichtung wird damit der Sprechakt selbst zur Quelle des Status Kunst.

Zweitens aber ist das Urteil »this is art« als kantisch-ästhetisches keine Privatdefinition, sondern erhebt den Anspruch der Universalität. Es geht über das bloß proklamierte Wohlgefallen hinaus, da es in der reflexiven Beurteilung des eigenen unmittelbaren Geschmacksurteils anhand der Zustimmung oder Ablehnung aller Anderen besteht; die Antizipation abwesender Urteile geschieht dabei vermittels dessen, was Kant die »erweiterte Denkungsart« des sensus communis genannt hat.7 Dessen Kriterium ist die Zustimmungsfähigkeit anderer Urteilender zum in der Deixis enthaltenen Urteil. Und zwar nicht allein, wie Hannah Arendt in ihrer Lesart heraushebt, der möglichen Anderen (dem Publikum der erweiterten Denkungsart oder der Menschheit als regulativer Idee), sondern auch der wirklichen, eine Urteilsgemeinschaft konstituierenden Anderen.8 Das Zurkunsterklären ist damit nicht nur ein isolierter Sprechakt, sondern eine eminent soziale Handlung; private ästhetische Urteile sind ebenso wenig möglich wie Wittgensteins Privatsprache und stets Teil einer kollektiven Lebensform.

Damit ist aber, drittens, etwas über diese wirklichen Anderen gesagt, insofern das Urteil diese Anderen als eines Urteils Fähige anerkennt. Einerseits heißt das: Urteile ich in der von Kant/de Duve/Arendt vorgestellten Form, affirmiere ich zwangsläufig die wirklichen anderen Urteilenden; ihr vorgestelltes Urteil ist Maßstab meines eigenen, das sie gerade in ihrer Fähigkeit als zu einem solchen Urteil Fähigen als kumulativer Standard meines eigenen anerkennt. Andererseits folgt: Ich verfüge mit dieser Anerkennung als Bedingung meiner eigenen Urteilskraft über einen Zugang zu der mich einschließenden Urteilsgemeinschaft, in deren Namen zu sprechen ich mir, da ich ihr Teil bin, auch selbst zutraue. Man urteilt nicht nur nicht allein, man bestätigt und repräsentiert auch immer ein Kollektiv von Urteilenden.

So liegt in de Duves Kant after Duchamp am Ende die sehr unkantische, aber durchaus Duchamp’sche Pointe, dass Kunst eben nicht autonom ist, sondern einzig Produkt sozialer Anerkennung – und zwar des Werks als Werk wie des Publikums als Publikum und beider zugleich als empirische Tatsache und als universaler Anspruch.

II.

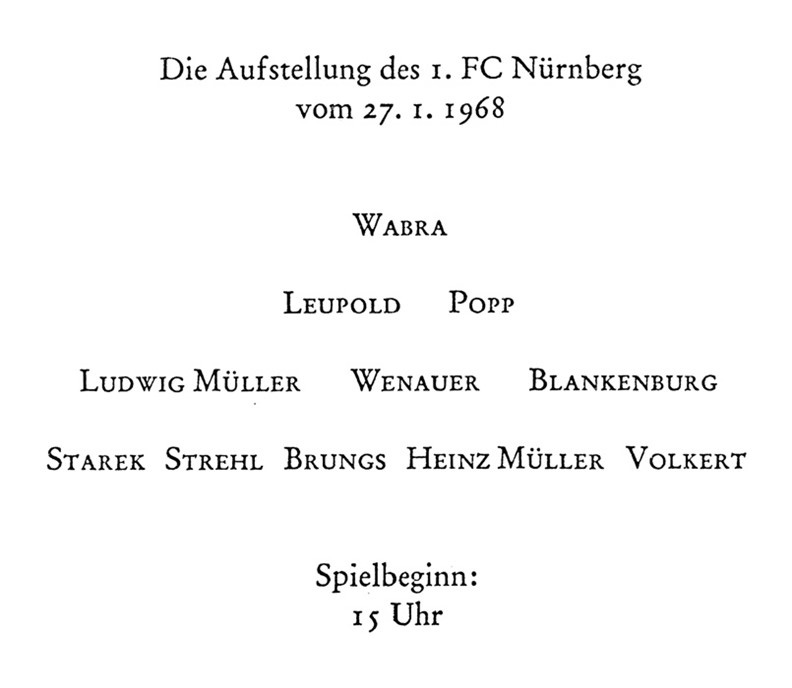

Nehmen wir einmal an, Ähnliches ließe sich auch für die Literatur behaupten. Diese bewusst reduktionistische Annahme hieße, literarische Texte unter Absehung solcher Kriterien wie historischer Situierung, diskursiver Anschlüsse, formaler und stilistischer Charakteristika, aber auch ihrer Disseminations- und Zugangsbedingungen zu betrachten. Dennoch ist diese Annahme als Minimalbedingung von Literatur nicht unplausibel. Dass die Deixis vor allem an ihren Rändern ihr einziges noch verbliebenes Kriterium ist, mag man an einem klassischen Beispiel für die Grenze von Literarizität ablesen, das in keiner Einführungsveranstaltung im Fach Germanistik fehlen darf: Peter Handkes »Die Aufstellung des 1. FC Nürnberg vom 27.1.1968« (Abb. 2). Dieser Text wird regelmäßig als literarisches Readymade bezeichnet,9 das allein durch seine Veröffentlichung im Band Die Innenwelt der Außenwelt der Innenwelt in der edition suhrkamp neben anderen literarischen Texten den Sprechakt impliziert: »this is literature.«

Trotz des differenten literarischen Systems, in dem sie ausgeführt wird, funktioniert diese Rahmungsgeste über Kon- und Paratext genauso als Deixis wie die kunstweltliche Rahmungsgeste Duchamps, der »Fountain« zur Schau der Society of Independent Artists eingereicht hatte; und deren Ablehnung, die anschließende Kontroverse und die Ausstellung in Alfred Stieglitz’ Galerie 291 stellten die Ernsthaftigkeit der Deixis ebenso wenig infrage wie Handkes leichte Eingriffe in die Startaufstellung.10 (Freilich ist Zeit zwischen Duchamp und Handke vergangen, die jene bei ersterem noch einfach konzipierte Deixis verkompliziert. So steht Handke wahrscheinlich statt Duchamp eher Andy Warhol näher, der komplexe Remediatisierungsprozesse thematisiert; dennoch ist das Prinzip der Rahmungsgeste dieselbe.)

In ihrem Plädoyer für einen »pragmatischen Literaturbegriff«, der sowohl extrinsische wie intrinsische Bestimmungen erfüllen soll, führen dann auch Fotis Jannidis, Gerhard Lauer und Simone Winko den Fußballtext Handkes als Beispiel für einen »institutionalisierten oder konventionalisierten Kontext« an: Texte in einem literarischen Werk sind als literarisch markiert.11 Weder hermeneutisch-ontologische noch formalistisch-strukturalistische noch marxistisch-materialistische Interpretationen können die Literarizität eines solchen Werks hinreichend erklären und selbst empirische oder diskursanalytische Zugriffe kommen in derartigen Grenzbereichen in Schwierigkeiten. Allein ein »pragmatischer« Literaturbegriff sei noch möglich. Und obwohl Jannidis, Lauer und Winko auch an den Kriterien von Fiktionalität und Poetizität festhalten wollen, können sie ihren eigenen Argumenten zufolge doch eigentlich allein die literarische Deixis in ihrem auf Familienähnlichkeit gebauten Begriff von Literatur – der das Literarische als ein vage Gemeinsames zwischen radikal verschiedenen Ausprägungen herausarbeiten will – als wirklich universales Kriterium verteidigen: Sicher lassen sich manche literarische Texte auch über Poetizität erklären, aber auch solche sind immer institutionalisiert und kontextualisiert. Poetizität ist also bestenfalls eine hinreichende, die Deixis dagegen eine notwendige Bedingung von Literatur.

Man mag einwenden, dass hier eine unzulässige Gleichsetzung von Kunst und Literatur vorgenommen werde, die ihre Spezifika ignoriere. Gerade das scheint mir aber irrelevant, wollte man die Deixis als ihr Gemeinsames bestreiten. Im Gegenteil, wendet man sich von den konventionalisierten Bereichen des Literarischen ab – die gar nicht in die Verlegenheit kommen, das in ihnen als literarisch Zählende bestimmen zu müssen –, wird man an seinen Rändern kaum anders als mit dem deiktisch aufgerufenen Geltungsanspruch weiterkommen können. Annette Gilbert hat diese pragmatische Grauzone als den »toten Winkel der Literatur« vor allem im Bereich des literarischen Konzeptualismus analysiert und bis in ihre Extreme verfolgt.12 Das von ihr untersuchte conceptual oder uncreative writing,13 das mit Formen der Appropriation, des Remix, der De- und Rekontextualisierung spielt, macht die Deixis des Zurliteraturerklärens zu ihrem Hauptinstrument – im äußersten Fall bis hin zur Auflösung des materiellen Gegenstands Buch wie des ideellen Textes selbst, wie Gilbert am Beispiel der Autorin Elisabeth Tonnard zeigt. Diese behauptet die Existenz ihres Invisible Book (2012) nur noch und verlässt sich allein auf Quittungen, ISBN-Einträge in Bibliotheken institutionelle Bekräftigung (in Gilberts Buch findet sich dann auch eine Rechnung über 0 €, die den Verkauf bestätigt).14 Hier ist das Werk (der infrage stehende Text, der Diskursakt, die literarische Kommunikation),15 ganz wie de Duve sagte, vor der Deixis unsichtbar geworden – und zwar tatsächlich und wortwörtlich. Natürlich ist in diesem Fall, wie übrigens auch bei Duchamp, das ästhetische Urteil keineswegs unumstritten. Es ist aber als solches offensichtlich in einem diskursiven Feld gefällt und kann angegriffen und verteidigt werden; Tonnards Insistenz, dass ihr unsichtbares Buch Literatur ist, ruft aktiv eine Urteilsgemeinschaft auf und bestätigt sie zugleich, wobei sowohl Widerstand wie Zuspruch als Erfolg dieser Anrufung gelten müssen.16

Ein Buch, aber als Geste: mehr Deixis und weniger Werk geht kaum. Zugleich allerdings, folgt man der hier vorgeschlagenen Minimallesart, geht auch kaum weniger an Bedingung für Literarizität: Nach Duchamp und dem konzeptuellen Schreiben ist die Diskussion, ob etwas Literatur sei, endgültig hinfällig. Alle konkurrierenden Kriterien – etwa die Evokation einer literarischen Tradition oder die Selbstreferenzialität von Sprache in Jakobsons poetischer Funktion – haben von nun an eine verminderte, nur noch für ausgewählte, nämlich »konventionelle« literarische Bereiche gültige Plausibilität. Deixis und das Kriterium der Anerkennung sind also auch, was literarische Werkschöpfung in ihrer absoluten Minimalform auszeichnen.

Aber gerade diese doppelte Anerkennung – die gleichzeitige Affirmation und Inanspruchnahme einer Urteilsgemeinschaft, der man selbst zugehört – ist nicht unendlich ausdehnbar. Ich erwähne Duchamp, de Duve und Tonnard nicht nur, um Gilberts »erweiterten Literaturbegriff« stark zu machen,17 sondern auch, weil sich an ihnen ein auf den ersten Blick unverwandtes Phänomen gut diskutieren lässt: die Autorschaft von Maschinen und der Status computergenerierter Literatur überhaupt.

III.

Unter generativer Literatur versteht man gemeinhin literarische Texte, die direkt aus der Ausführung von formalisierten, in Programmiersprachen niedergelegten Algorithmen hervorgegangen sind oder über große Sprachmodelle der künstlichen Intelligenz (large language models, LLMs) wie ChatGPT, Gemini oder Claude hergestellt wurden.18 In diese breite Kategorie gehören sowohl die ältesten Beispiele computergenerierter Literatur überhaupt – wie Christopher Stracheys »Love Letters« (1952) oder Theo Lutz’ »Stochastische Texte« (1959) – als auch neueste, mit großen Sprachmodellen erstellten Arbeiten – etwa K Allado-McDowells Air Age Blueprint (2022) oder mein eigener KI-Roman (Berlin, Miami) (2023).19

Alle diese Texte haben gemein, dass sie nicht Folge eines unmittelbaren Akts der Niederschrift durch eine:n menschliche:n Autor:in sind, ganz gleich, ob das Schreibinstrument dabei der Stift oder das Textverarbeitungsprogramm ist. Im Gegensatz zu einer solchen unmittelbaren (primären) Autorschaft sind die Werke generativer Literatur das Ergebnis einer mittelbaren Autorschaft.20 Sind sie durch die Ausführung eines Codes entstanden (Text, der einen Text hervorbringt), spreche ich von »sekundärer Autorschaft« (Strachey, Lutz); sind sie die Folge von KI-Modellen, bei denen die Wahl der Parameter selbst festgelegt wurde – der zum Training verwendete Datensatz, die Dauer (»Epochen«) des Trainings, Parameter wie die »Temperatur« (Zufälligkeit des Outputs) etc. –, spreche ich von »tertiärer Autorschaft« ((Berlin, Miami)). »Quartäre Autorschaft« schließlich bezeichnet Texte, die durch proprietäre Systeme wie ChatGPT oder GPT-3 ohne solche Einstellungsmöglichkeiten produziert wurden (Air Age Blueprint).

Da sich die Germanistik überwiegend mit der ersten, der primären Autorschaft auseinandergesetzt hat – auch wenn seit den 1960er-Jahren vereinzelt Diskussionen sekundärer Autorschaft aufkamen21 und sie vor allem in den 1990er-Jahren im Rahmen der Hypertextliteratur zum Thema wurde22 –, wird der Status gerade ihrer tertiären und quartären Kategorien angesichts großer Sprachmodelle heute zunehmend zum literaturtheoretischen Problem.23 In welcher Weise können Algorithmen oder KI-Sprachmodelle selbst Autorschaft beanspruchen? Und inwiefern ist diese Autorschaft an die Fähigkeit zur Deixis gebunden, die ein Werk erst als Werk auszeichnet?

Oft verblieb man in früheren Diskussionen auf der Produktionsseite. So popularisierte Espen Aarseth bereits 1997 – damals noch in Bezug auf mittels klassischer Algorithmen generierte Literatur – den Begriff der cyborg authorship: Kein Computer könne alleinige Autorschaft beanspruchen, aber je komplexer sich das Zusammenspiel aus preprocessing (Vorbereiten des Programms und der Daten), coprocessing (Ausführung und iterative Anpassung des Programms) und postprocessing (Korrektur und Publikation) gestalte, desto eher müsse man der Mensch-Computer-Assemblage, also einem Cyborg, Autorstatus zuschreiben.24 Künstler:innen sind dieser Aufforderung freilich selten gefolgt. Bis auf sehr wenige Ausnahmen tatsächlich eingeforderter Computerautorschaft berühmtestes Beispiel wäre hier The Policeman’s Beard is Half Constructed (1984),25 das im Paratext das Programm Racter als Autor auswies – sind in den meisten Fällen Maschinen nur künstlerische Werkzeuge. Mit einer Analogie des KI-Künstlers Mario Klingemann gesprochen: So, wie man dem Klavier nicht die Sonate zuschreibt, sollte generierte Kunst nicht der generierenden, sondern der konzeptualisierenden Instanz zugeschrieben werden – also dem Menschen dahinter.26

In der Informatik, der KI-Entwicklung und vor allem der computational creativity wird die Frage, ob Computer Autor:innen sein können, dagegen oft heuristisch bejaht und als zu lösendes Problem beschrieben.27 Ihre Fragen lauten: Wie wären Programme zu entwerfen, die ihrer Funktionslogik nach gemeinhin mit Kunstschaffenden assoziierte Fähigkeiten simulieren (meist ist das: Kreativität) oder die wesentlich im Kunstwerk liegende Eigenschaften (also eine irgendwie modellierbare »Kunsthaftigkeit«) reproduzieren?28 Trotz einiger neuerer Versuche, diese Forschung für die soziale Einbettung der so designten Modelle zu öffnen,29 geht es hier doch im Wesentlichen um modellimmanente Perspektiven. Will man hier nicht hinter einen modernen Kunst- und Literaturbegriff zurückfallen, müsste das bedeuten, auch die werkkonstitutive Deixis – in der bei Duchamp und Handke der »kreative« Akt bestand – durch ein solches Modell zu replizieren; es müsste in der Lage sein auf etwas zu zeigen und zu sagen: »this is art«.

Hier wird deutlich, dass die Produktionsseite in der technischen wie der künstlerischen Herstellung von generierten Texten nicht von der Rezeption zu trennen ist. Sind Kunst und Literatur kein ontologisches Faktum, sondern fait social, ist Kunsthaftigkeit gerade nicht im Objekt lokalisiert, sondern – im Extremfall analog zu Duchamps Zeigegeste – Effekt diskursiver und institutioneller Aushandlungsprozesse und schließlich eben auch der Anrufung einer Urteilsgemeinschaft, dann muss die Rezeptionsperspektive eine mindestens ebenso große, wenn nicht die größere Rolle spielen. Die Frage lautet dann: Wie werden generierte Texte rezipiert? Welche Erwartungshaltung wird an sie getragen und werden Urteile über sie gefällt? Und das heißt auch: Welchen Status hat hier die doppelte Anerkennung, die ich am Beispiel von Duchamp diskutiert habe?

IV.

Dieses Zusammenspiel von Produktion und Rezeption ist auch der KI-Forschung nicht entgangen, wenngleich sie es kaum theoretisiert hat. Im Bereich der tertiären und quartären Autorschaft, also im Schreiben mit KI, scheinen zwei grundsätzliche Tendenzen vorzuherrschen, wenn es um die intendierte Rezeption geht, also diejenige, wie sie von den Erbauer:innen der Systeme erwartet und begrüßt wird. Die erste ist Täuschung, die zweite Kosozialität. Beide sind auf verschiedene Weisen problematisch.

In der ersten Tendenz geht es darum, agency, Intentionalität und letztlich Autorschaft zu simulieren, aber nicht (oder nicht allein) dadurch, dass man sie auf Objektseite mit technischen Mitteln herstellt – also durch das, was John Searle »strong AI« nennt und was die computational creativity in ihren ambitionierteren Momenten versucht –, sondern dadurch, dass man Mittel ergreift, sie auf Rezeptionsseite vorzutäuschen. Das ist bekanntermaßen die Grundlage von Alan Turings imitation game, später »Turing-Test« genannt: Wenn ein menschlicher Akteur die textlichen Ausgaben eines Computers nicht von der eines Menschen unterscheiden kann, müsste der Computer funktional als intelligent gelten, da, gut behavioristisch, Geist anders als in seinen Effekten gar nicht messbar ist.30

Will man die Erwartungshaltung an computergenerierte Texte diskutieren, ist der Turing-Test immer noch ein guter Ausgangspunkt.31 Das Grundprinzip des imitation game ist, wie Simone Natale in seinem Buch Deceitful Media festhält, eben das: Imitation, Täuschung. In der Tat sieht Natale darin das konstitutive Prinzip aller KI: »Deception is as central to AI’s functioning as the circuits, software, and data that make it run.« In der KI-Forschung hat sich der Begriff von Intelligenz als Folgeeffekt manipulierter Erwartung entwickelt: Ziel war implizit stets »the creation not of intelligent beings but of technologies that humans perceive as intelligent«.32

Was bedeutet diese starke Täuschung, die auf einer Wissen-/Macht-Asymmetrie zwischen der menschlichen Person und dem Design der KI-Instanz basiert, für die Rezeptionserwartung an KIs? Mit einem Wort: nichts. Sie müsste dieselbe sein wie für Menschen, weil sie Menschen erwartet – aber dann auch nur für Menschen gilt. Starke Täuschung sieht nicht vor, dass sich der Status der Anerkennung von Computern ändert, sondern dass ihnen – fälschlich und trügerisch – der Status von Menschen zugesprochen wird. Auf literarische und künstlerische Werke übertragen: KIs haben hier gerade nicht die Fähigkeit zur Deixis und Anspruch auf die Anerkennung als Teil einer Urteilsgemeinschaft – denn würden sie als KIs entlarvt, müsste man ihnen diese Fähigkeit prompt wieder entziehen, da sie nicht als eines Urteils Fähige anerkannt werden. Die Form des Urteils als menschliches bleibt unangetastet.

Natale sieht aber auch eine schwächere Form vor, die er »banal deception«, banale Täuschung nennt. Sie ist für ihn schlicht ein Interfacefeature vieler Medien, »deceptive mechanisms and practices that are embedded in media technologies and contribute to their integration into everyday life«.33 Von solchen Mechanismen wissen wir, dass sie nicht intentional sind und unterstellen ihnen doch Intentionalität. Wir sind uns bewusst, dass Siri kein Mensch ist, aber die reibungslose Kommunikation mit ihr funktioniert nur dann, wenn wir die KI zumindest ansatzweise so behandeln. Hier wäre die Bewusstheit der eigenen Täuschung kein Widerspruch, sondern gerade Bedingung für Funktionalität. Banale Täuschung ist also Täuschung mit dem impliziten Einverständnis der Getäuschten – wobei stets zu fragen ist, wie freiwillig dieses Einverständnis wirklich ist und welche Kontrollfunktion dadurch ausgeübt werden.

Als ästhetisches Korrelat dieser banalen Täuschung schlug Natale zusammen mit der Medienwissenschaftlerin Leah Henrickson den Lovelace-Effekt vor. Benannt ist er nach Ada Lovelace, der ersten »Programmiererin«, die für Charles Babbages analytical engine Operationsabläufe entwickelte. In einem Kommentar zu Babbages Schriften stellte sich Lovelace auf die Position, dass eine Maschine prinzipiell nichts Neues hervorbringen in der Lage sei, da alle ihre Produkte auf die Anweisungen des Menschen zurückgeführt werden könnten, der den Programmiercode schrieb; dabei warnte Lovelace davor, dass Menschen fälschlicherweise diese Idee auf die Maschine projizieren könnten.34 Natales und Henricksons Lovelace-Effekt hat das Ziel »to describe situations in which the behaviour of computing systems is perceived by users as original and creative«.35 Ästhetische Neuheit wird damit ebenso zu einer Projektion wie Intentionalität, die durch bestimmte Aspekte und Kontexte noch verstärkt werden kann: Natale und Henrickson nennen das Beispiel eines Galeriesettings, das die dort ausgestellten KI-generierten Bilder als Kunstwerke markiert. Der Lovelace-Effekt beruht daher durchaus auf der Deixis des institutionellen Rahmens – wobei er aber gerade keine Sache von starker Täuschung ist, sondern das Sicheinlassen auf die Fiktion bezeichnet, es sei eine KI für die gezeigten Bildwerke in einem starken Sinne verantwortlich.

Können nun banale Täuschung und der Lovelace-Effekt auch auf die Erwartungshaltung gegenüber generierten literarischen Werken übertragen werden? Leah Henrickson stellt in ihrem Buch Reading Computer-Generated Texts auch hierfür ein Modell vor. Jedes Text-Leser:innen-Verhältnis sei durch einen hermeneutic contract bestimmt: »Readers believe that authors want readers to be interested in their texts, and that authors want readers to understand their texts.«36 Von jedem Text, den wir lesen, nehmen wir zunächst an, dass er um einer kommunikativen Handlung willen hervorgebracht ist. Henrickson nun ist der Meinung, dass der hermeneutic contract auch für computergenerierte Texte gilt, und zwar durch den Lovelace-Effekt, die ästhetische banale Täuschung. Lesende projizieren Intentionalität auf den Algorithmus, den Computer, die KI, um die Standarderwartung an Texte erfüllen zu können:

Regardless of whether the author is a human or a non-human entity, the reader infers the intentions of an imagined and disembodied author based on a process of meaning-making that rests upon the assumption of mutual understanding through shared sociocultural traditions. To investigate intention by necessity assumes agency. It is therefore not enough to merely say that NLG [natural language generation] systems are tools, or even social actors. They are social agents, because readers treat them as such.37

Doch damit schlägt bei Henrickson die Erwartungshaltung an generierte Texte unter der Hand vom Paradigma der bewussten Selbsttäuschung in das der Kosozialität um. Die fiktive Modalität wird zur assertorischen, das Als-Ob zum Sein. In diesem Fall wird der Computer zum sozialen Agenten, weil wir ihn so behandeln. Der Philosoph Daniel Dennett hat das unter dem Titel der intentional stance diskutiert: Jedes System ist, qua seines Gemachtseins, bereits ein kausaler Index, eine Spur, die auf eine ihn verursachende Instanz hinweist, und von der man wiederum annimmt, dass sie die Verursachung dieser Spur gewollt hat, um etwas auf Rezeptionsseite zu bewirken.38 Aber bedeutet das wirklich die Angleichung menschlicher und nichtmenschlicher Autorschaft in der Erwartungshaltung gegenüber generierten Texten?

V.

Im Gegensatz zur Täuschung, bei der das Systemdesign darauf ausgelegt ist, User:innen menschliche Aktivität vorzuspielen, benennt Kosozialität die Position, die Computer und KI-Systeme als tatsächlich mit sozialer Handlungsmacht ausgestattet versteht. Statt der arglistigen Täuschung, die den Turing-Test auszeichnet, läge einem Ansatz der Kosozialität der von Susan Leigh Star vorgeschlagene »Durkheim-Test« zugrunde.

Stars Durkheim-Test setzt den Schwerpunkt der Bewertung eines KI-Systems auf seine Fähigkeit, soziale Ziele innerhalb einer Gemeinschaft zu erfüllen. Im Gegensatz zur isolierten psychologischen Simulation des Turing-Tests konzentriert sich dann der Durkheim-Test auf die Bewertung der Fähigkeit des Systems, die eine auf verschiedene Aktanten verteilte Zusammenarbeit durch die Einbeziehung diverser Perspektiven zu unterstützen:

The Durkheim test would be a real time design, acceptance, use and modification of a system by a community. Its intelligence would be the direct measure of usefulness applied to the work of the community; its ability to change and adapt, and to encompass multiple points of view while increasing communication across viewpoints or parts of an organization.39

Statt also auf Täuschung abzuzielen, geht es nun um die Anerkennung der Praxisgemeinschaft der mit dem System Interagierenden in einem sozialen Nutzungskontext. Hatte Star hier noch, relativ technisch gedacht, die Entwicklung wirklicher multiagent AI im Sinn, könnte man den Durkheim-Test aber allgemeiner interpretieren: Nämlich als Kriterium für die Anerkennung eines KI-Systems als tatsächlich sozialer Agent aus der Perspektive der mit ihm Interagierenden. So verstanden fragt der Durkheim-Test gewissermaßen die Mitgemeinschaftlichkeit des Systems ab (wobei Star freilich den genauen Versuchsaufbau im Dunkeln lässt, der ihn zu einem operationalisierbaren Test machen würde).

Auch hierbei gibt es schwächere und stärkere Formen. Die stärkstmögliche Version von Kosozialität würde Maschinen welcher Art auch immer tatsächlich als menschengleiche soziale Akteure anerkennen, und zwar ganz ohne die Krücke banaler Täuschung. Mir ist keine Position bekannt, die diese Möglichkeit für die Gegenwart ernsthaft behauptet – einzig vielleicht die Blake Lemoines, jenes Google-Mitarbeiters, der im Juni 2022 entlassen wurde, weil er das Sprachmodell LaMDA für mit Bewusstsein ausgestattet hielt.40 Eine solche Extremhaltung wäre auch von den Versuchen der computational creativity zu unterscheiden, der es zunächst nur um die Herstellung kreativer Maschinen geht; über ihre Anerkennung als soziale Agenten ist damit noch gar nichts gesagt. Solche Kosozialität ist außerdem selbst wieder ein Rezeptionseffekt und durch keine Technik, wie gut sie auch sei, immanent zu bewerkstelligen.41 Auch die schlaueste und kreativste KI ist noch nicht an sich Akteur und selbst eine Figur wie Xiao Bing – die chinesische KI-Persona, die Gedichte schreibt und in Fernsehsendungen auftritt – wird noch unter dem Aspekt des Als-Ob betrachtet, weil ihre Anerkennung immer nur in Teilkontexten gilt.42

Existierende Interpretationslinien argumentieren schwächer und orientieren sich etwa an der Akteur-Netzwerk-Theorie. Sie heben auf Mensch-Maschine-Assemblagen ab, so dass in der Rezeption von computergenerierten Texten Autorschaft über ein System aus Akteuren verteilt gedacht ist, statt wirklich einzelnen KIs zugesprochen zu werden.43 Aarseths cyborg authorship nannte ich bereits. Auch Henrickson lässt diese Position zu, bevorzugt aber eigentlich eine sehr viel emphatischere Haltung: Algorithmen sind nicht allein Akteure – also ein Netzwerkknoten »that does modify a state of affairs by making a difference«,44 wie Latour in Reassembling the Social schreibt –, sondern sie erscheinen Lesenden als selbstbestimmte Agenten, denen – qua hermeneutical contract – sowohl Intentionalität als auch kommunikative Absicht unterstellt wird.

Henrickson erscheint diese Unterstellung ein epistemisches Artefakt der Lesesituation selbst zu sein: Ohne Intentionalität und kommunikative Absicht anzunehmen, stünde man dieser Annahme nach generierten Texten hilflos gegenüber. Der hermeneutical contract verwandelt sich im Theoriedesign also von einem Standard der Rezeption zur

Ermöglichungsbedingung von Rezeption. Damit wird einerseits bestätigt, dass Lesende die einem gedachten Autor gegenüber eigentlich sinnstiftende Instanz sind; zugleich aber geschieht diese Sinnstiftung über eine bewusste Selbsttäuschung über die agency von Algorithmen – Kosozialität kommt so paradoxerweise durch banale Täuschung zustande.

An diese Interpretationslinie kann man zumindest ein paar Fragen richten. Erstens wäre das: Wie notwendig ist die Annahme von Intentionalität für die Rezeption generierter Texte, die Henrickson wie Dennett als so wesentlich ansehen? Es ist verschiedentlich, vor allem aus der Richtung der Systemtheorie, bestritten worden, dass Kommunikation notwendig als intentionaler Akt von individuellen Subjekten gedacht werden muss. In ihrem Buch Artificial Communication hat Elena Esposito zuletzt dafür argumentiert, statt von künstlicher Intelligenz von künstlicher Kommunikation zu sprechen. Auch Esposito meint, dass wir uns durchaus bewusst sind, mit nichtmenschlichen Maschinen zu sprechen; aber die Kommunikation mit ihnen erfordert keine Annahme von Intentionalität und das hermeneutische Verschmelzen mentaler Prozesse, sondern lediglich die Produktion von Information aus der Beobachtung von kontingentem Verhalten. Das leisten laut Esposito moderne, stochastischen Machine Learning-Systeme, da sie, anders als klassische Algorithmen, keine klar deterministische Vorhersagbarkeit mehr erlauben, sondern echt kontingenten Output produzieren (dass dieser Interpretation auf technischer Seite widersprochen werden kann, übergehe ich hier). Sie seien so echte Kommunikationspartner – ohne psychologische Zusatzannahmen und ohne die banale Täuschung, die bei Henrickson noch nötig ist, da das Funktionieren von Kommunikation allein aufseiten der Empfänger:innen zu finden ist. Esposito erlaubt zumindest die Möglichkeit, Kosozialität unter der Schwelle eines menschengleichen Akteursstatus zu erreichen – allerdings um den Preis eines bewusst reduzierten Kommunikationsbegriffs. Dessen systematisches Problem besteht vor allem darin, dass er die neue Situation nicht zu erfassen erlaubt, die erst mit der Realität von generierten Texten zutage getreten ist, die sich als solche nicht mehr von menschengeschriebenen unterscheiden lassen: dass nämlich bisher unbekannte Texte standardmäßig (wenn meist nur implizit) als von Menschen geschriebene behandelt wurden und damit die »doppelte Kontingenz« immer mit Zusatzannahmen einhergegangen ist, die man nicht einfach verlustlos auf Maschinen übertragen kann .45 Die Wirksamkeit dieser Annahme macht erst die Täuschung möglich, die etwa automatisierte Desinformation darstellt; und als Täuschung ist sie gerade keine Kosozialität.

Zweitens kann man an Henrickson – aber auch an andere kosoziale Ansätze – die Frage richten, ob das Modell in Bezug auf die Erwartungshaltung nicht zu statisch gedacht ist. Es ist richtig, dass die Standardsituation von Rezeption noch das Lesen von Texten menschlicher Autoren ist. Bei Henrickson wird sie plausiblerweise auf eine neue Situation übertragen – sie wirkt aber kaum auf diesen Standard zurück. Muss das so sein? Es wäre zumindest denkbar, dass die zunehmende Interaktion mit Maschinenkommunikation uns dazu bringt, den hermeneutic contract abzuändern, weil sich der Standard aufweicht, der ihn ursprünglich definiert hat. Damit müsste er nicht notwendig auf das Sprechen mit KIs und automatisierten Systemen ausgeweitet, sondern könnte, im Gegenteil, überhaupt als Standard in Frage gestellt werden.46 Man kann sich, anders gesagt, eine Situation vorstellen, in der nicht Maschinen und Algorithmen als »Autoren« akzeptiert werden, sondern, andersherum, die Herkunft eines Textes zunächst agnostisch behandelt wird, so dass dessen »natürliche« oder »künstliche« Faktur gar nicht erst zur Basis aller weiteren Bewertungen wird. Entsprechend wären so begutachtete Produkte nicht mehr artifizielle, sondern eben post-artifizielle Kommunikation oder Texte. Erst damit wäre tatsächlich und empirisch eingetreten, was Poststrukturalismus und eine kybernetisch inspirierte Literaturwissenschaft jeher als abstraktes Lektüremodell vorgeschlagen haben (und das durch jedes feuilletonistische Autor:innenporträt und jede autofiktionale Erzählstrategie unterlaufen wird). Ich habe diese Möglichkeit andernorts diskutiert.47

Drittens kann man auch ganz pragmatisch fragen, wie weit die Unterstellung von Kosozialität wirklich geht und worin sie ihre Grenzen hat. Es ist richtig, dass ich mit Siri nur dann richtig umgehen kann, wenn ich sie zumindest habituell, im Sinne einer banalen Täuschung, als Person behandle. Aber ist damit wirklich ästhetische Kosozialität gemeint, die Autor- oder auch nur Urheberschaft ja grundsätzlich vorauszugehen hat und die im Zusammenhang mit literarischen oder künstlerischen Werken über das moderne ästhetische Urteil funktioniert, das de Duve in Duchamps »this is art« erkennt? So komme ich endlich zum Beginn zurück: Angenommen, Kunst und Literatur und damit Autorschaft wären tatsächlich auf diese Deixis reduzierbar; und sie zöge zudem den Anspruch auf Universalität in der Anrufung des sensus communis nach sich; und es wären in ihr auch die Anerkennung der Urteilenden als Teil einer Urteilsgemeinschaft berührt, die nicht allein empirisch, sondern auch als nur vorgestellte gedacht ist – wäre diese Kosozialität noch durch eine KI einholbar?

VI.

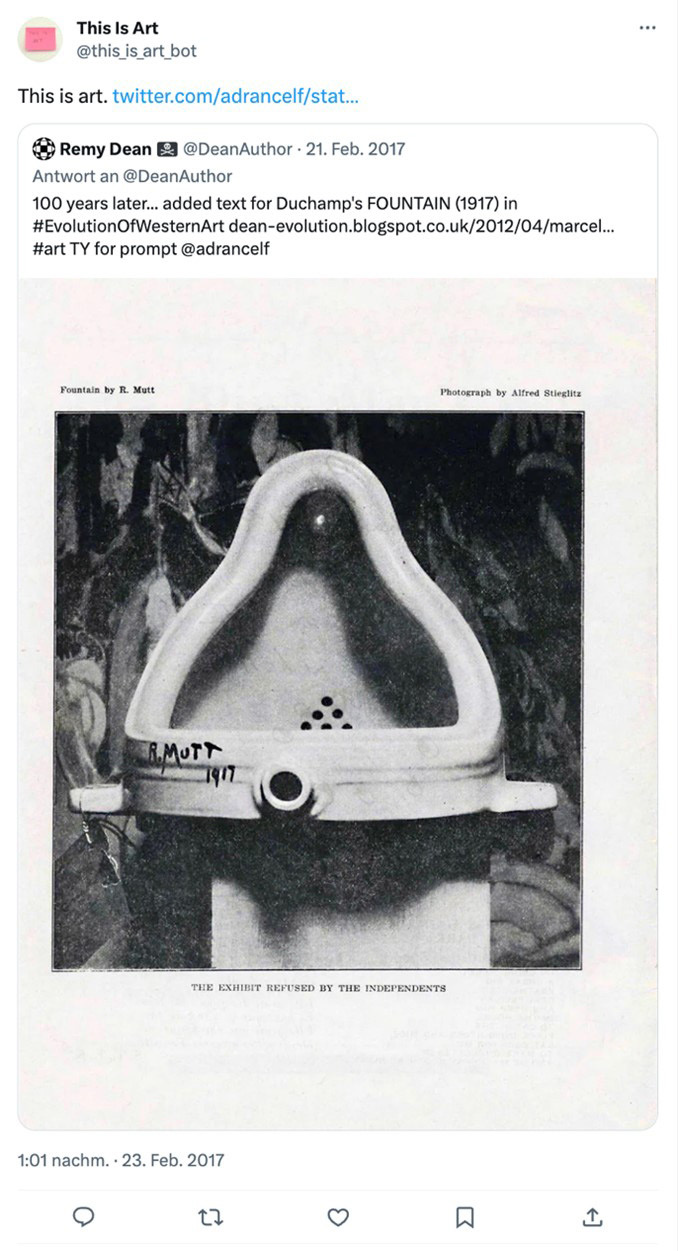

»This is art«, sagte Duchamps »Fountain«. »This is art«, sagt auch der @this_is_art_bot, den die Künstlerin Anna Franková von 2016 bis 2017 ein Jahr lang auf Twitter losließ. Tweets, die den Hashtag #art trugen, wurden mit der Nachricht »this is art« automatisiert retweetet. Neben einer Vielzahl von recht offensichtlichen Fällen von Privatgemaltem oder Museums-Selfies zählte unter das Retweetete auch, wieder einmal, das Urinal Duchamps.48 Is this art? Ja, aber das war es vorher schon, wie auch in den anderen Fällen »this is art« nur unter der Bedingung einer vorgängigen Deixis (dem Hashtag #art) möglich war. Kann also ein Bot wirklich diese Deixis ausführen? Wohl nicht – jedenfalls nicht unter den heute gegebenen Erwartungsbedingungen an diese Geste.

Offensichtlich ist der Begriff der Anerkennung, den Theorien der Kosozialität aufrufen, begrenzt, und der jener ästhetischen Deixis, wie ich sie hier skizziert habe, ungleich anspruchsvoller: Eine bloße banale Täuschung oder ein kontrafaktischer hermeneutic contract jedenfalls reichen nicht hin, sie einzuholen. Zugleich ist in dieser Deixis auch keine Kommunikation oder unterstellte Intentionalität das Ausschlaggebende, auch nicht, wie in der klassischen KI-Forschung, hauptsächlich Intelligenz. Stattdessen ist es das Kriterium der Anerkennung als Teil der und durch die Urteilsgemeinschaft. 49 Würde »Sozialität« an ihr gemessen, wäre sie erst durch eine wirkliche ästhetische Mitgemeinschaftlichkeit mit Maschinen erreicht. Wie die Gegenüberstellung von Turing- und Durkheim-Test gezeigt haben, sind KI-Systeme im Moment aber noch radikal solipsistisch.

An dieser Stelle wird auch klar, dass sowohl der hermeneutic contract wie die systemtheoretische Kommunikation davon immer noch weit entfernt sind. Denn zwar ist es auf den ersten Blick nicht völlig unplausibel, auch das ästhetische Urteil als kontrafaktisches, »kontraktuales« vorzustellen – so, als gäbe es nicht nur banale Täuschung, sondern auch banales unterstelltes Urteilen. Aber offensichtlich ist diese Operation sehr viel anspruchsvoller als imaginierte Intentionalität (das »Etwas-sagen-Wollen« in Henricksons hermeneutic contract) und scheitert im Moment noch an der der fehlenden reziproken Anerkennung von Urteilsgemeinschaft und Urteilfällendem. Wie gesagt: im Moment; denn undenkbar ist es gerade nicht, dass auch Maschinen solche Urteile zu fällen imstande wären – aber dazu müsste sich eben die Erwartungshaltung so ändern, dass ihnen dieser Status zuerkannt würde. Eine echte ästhetische Kosozialität wäre dann in eine starke Version des Durkheim-Test zu integrieren: Erst, wenn eine KI – ohne als Mensch ausgegeben zu werden – erfolgreich die Deixis vollzieht, die Frankovas Bot so pausen- wie eben auch folgenlos nur andeutet, kann echte KI-Autorschaft in einem emphatischen Sinn als erreicht gelten. Bislang fehlt der Deixis, die von einer Maschine ausgeht, noch die illokutionäre Wucht dazu, verbleibt im Schauspiel, statt die Sache selbst zu tun.

Der Durkheim-Test (dessen genaue Parameter freilich noch zu definieren wären) markiert einen maximal anspruchsvollen Grenzbegriff von Anerkennung, der aus Deixis als Minimalbedingung von Kunst und Literatur resultiert. Er muss als ebenso wenig bestanden gelten wie der Turing-Test – er wäre sogar schwerer zu bestehen. Damit ist es zwar nicht unmöglich, aber sehr viel wahrscheinlicher, sich irgendwann dauerhaft mit einer täuschend intelligent erscheinenden KI zu unterhalten, als die Geste des Zurkunsterklärens einer ästhetischen KI zu akzeptieren, die auf einen Gegenstand zeigt und sagt: »this is art.«

- 1. Dieser Text hat seinen Ursprung in einem Vortrag, den ich auf dem 27. Deutschen Germanist:innentag 2022 in Paderborn gehalten habe. Ich danke Annette Gilbert, Stephanie Catani, Marlene Meuer, Jules Pelta Feldman, Niels Penke, Sandro Zanetti und dem:der anonymen Reviewer:in für hilfreiche Kommentare. Seine Ausarbeitung wurde gefördert durch ein Grant der VW-Stiftung. Der vorliegende Essay erschien zuerst in englischer Fassung als: »The Deixis of Literature. On the Conditions for Recognizing Computers as Authors«. In: Orbis Litterarum (2024), online first, DOI: 10.1111/oli.12450.

- 2. Irene Gammel: Baroness Elsa. Gender, Dada, and Everyday Modernity. A Cultural Biography. Cambridge / MA 2003, S. 224. Dieser Vorwurf ist umstritten.

- 3. Thierry de Duve: Kant after Duchamp. Cambridge / MA 1996, S. 347.

- 4. Ebd., S. 453.

- 5. Joseph Beuys: Jeder Mensch ist ein Künstler. Gespräche auf der documenta 5/1972. Hg. v. Clara Bodemann-Ritter. Frankfurt am Main 1975.

- 6. Vgl. Howard Becker: Art Worlds. Berkeley 1982; Linda Nochlin: »Why Have There Been No Great Women Artists?« In: Dies.: Women Artists. The Linda Nochlin Reader. Hg. v. Maura Reilly. London 2020, S. 42–68.

- 7. Immanuel Kant: Kritik der Urteilskraft. Hg. v. Heiner F. Klemme. Hamburg 2001, B 158f.

- 8. Hannah Arendt: Das Urteilen. Texte zu Kants politischer Philosophie. Hg. v. Ronald Beiner. München 1985, v. a. S. 96. Vgl. dazu Ronald Beiner, der in dieser Interpretation den Versuch Arendts erkennt, Kant zu »detranszendentalisieren«: Ronald Beiner: »Rereading Hannah Arendt’s Kant Lectures«. In: Ders. u. Jennifer Nedelsky (Hg.): Judgment, Imagination, and Politics. Themes from Kant and Arendt. Oxford 2001, S. 91–102, hier S. 96. Vgl. auch Hannes Bajohr: Dimensionen der Öffentlichkeit. Politik und Erkenntnis bei Hannah Arendt. Berlin 2011, S. 95–106.

- 9. Vgl. etwa Thomas Wegmann: »So oder so. Die Liste als literarische Kippfigur«. In: Ders. u. Norbert Christian Wolf (Hg.): »High« und »low«. Zur Interferenz von Hoch- und Populärkultur in der Gegenwartsliteratur. Berlin 2012, S. 217–231 und Lukas J. Bodom: »Elf Freunde oder eine Allegorie auf den Nationalsozialismus? Über Peter Handkes Die Aufstellung des 1. FC Nürnberg vom 27.1.1968«. In: Wirkendes Wort 70.2 (2020), S. 279–285.

- 10. Handke änderte die Anstoßzeit von 14:00 auf 15:00 Uhr und gab nicht die Startaufstellung an, sondern die des Abpfiffs, vgl. Bodom, »Aufstellung«, S. 283. Ein weiterer Unterschied besteht darin, dass nicht Horst Leupold links in der Verteidigung stand, sondern Helmut Hilpert, vgl. Wegmann, »So oder so«, S. 227.

- 11. Fotis Jannidis, Gerhard Lauer u. Simone Winko: »Radikal historisiert: Für einen pragmatischen Literaturbegriff«, in: Dies. (Hg.): Grenzen der Literatur. Zu Begriff und Phänomen des Literarischen. Berlin 2009, S. 3–37, hier S. 31.

- 12. Annette Gilbert: Im toten Winkel der Literatur. Grenzfälle literarischer Werkwerdung seit den 1950er Jahren. Paderborn 2018.

- 13. Vgl. Kenneth Goldsmith: Uncreative Writing. Sprachmanagement im digitalen Zeitalter. Berlin 2017 sowie Robert Fitterman u. Vanessa Place: Covertext. Anmerkungen zu Konzeptualismen. Berlin 2013.

- 14. Elisabeth Tonnard: The Invisible Book. 2. Aufl. Leerdam 2012; vgl. Gilbert: Im toten Winkel der Literatur, S. 61.

- 15. Zum komplexen Status des Werkbegriffs – der durch den Poststrukturalismus ebenso wenig tatsächlich überwunden worden ist wie der Begriff des Autors –, siehe Lutz Danneberg, Annette Gilbert u. Carlos Spoerhase (Hg.): Das Werk. Zum Verschwinden und Fortwirken eines Grundbegriffs. Berlin 2019.

- 16. Die Kunstwissenschaftliche Bibliothek Berlin etwa führt das Invisible Book in ihrem Katalog, was einer institutionellen Anerkennung gleichkommt – freilich mit der Anmerkung »Das Exemplar der Kunstbibliothek ist nur in dieser Anzeige zu finden!« https://opac.smb.spk-berlin.de//DB=2/CMD?ACT=SRCHA&IKT=12&TRM=840693133.

- 17. Gilbert: Im toten Winkel der Literatur, S. 28.

- 18. Vgl. Scott Rettberg: Electronic Literature. Cambridge 2019; Stephanie Catani: »Generierte Texte. Gegenwartsliterarische Experimente mit Künstlicher Intelligenz«. In: Andrea Bartl, Corina Erk u. Jörg Glasenapp (Hg.): Schnittstellen. Wechselbeziehungen zwischen Literatur, Film, Fernsehen und digitalen Medien. Paderborn 2022, S. 247–266; Hannes Bajohr: Schreibenlassen. Texte zur Literatur im Digitalen. Berlin 2022; Simon Roloff u. Hannes Bajohr: Digitale Literatur zur Einführung. Hamburg 2024.

- 19. Christopher Strachey: »The ›Thinking‹ Machine«. In: Encounter 3 (1954), S. 25–31; Theo Lutz: »Stochastische Texte«. In: augenblick 4.1 (1959), S. 3–9; K Allado-McDowell: Air Age Blueprint. London 2022; Hannes Bajohr: (Berlin, Miami). Berlin 2023.

- 20. Die Unterscheidung zwischen primärer, sekundärer und tertiärer/quartärer Autorschaft führe ich im Detail aus in: Hannes Bajohr: »Writing at a Distance. Notes on Authorship and Artificial Intelligence«. In: German Studies Review 46.1 (2024), S. 315–337 Eine Kurzversion findet sich in: Hannes Bajohr: »Autorschaft und Künstliche Intelligenz«. In: Stephanie Catani u. Jasmin Pfeiffer (Hg.): Handbuch Kunst und Künstliche Intelligenz. Berlin 2023, S. 265–280.

- 21. Nur zwei Beispiele: Siegfried J. Schmidt: »Computopoeme«. In: Bit 5/6 (1969), S. 117–130; Max Bense: »Die Gedichte der Maschine der Maschine der Gedichte. Über Computer-Texte«. In: Ders.: Die Realität der Literatur. Autoren und ihre Texte. Köln 1971, S. 74–96.

- 22. Vgl. Roberto Simanowski: »Autorschaften in digitalen Medien. Eine Einleitung«. In: Text+Kritik 152 (2001), S. 3–21; Florian Hartling: Der digitale Autor. Autorschaft im Zeitalter des Internets. Bielefeld 2009.

- 23. Einen ersten Überblick bietet: Jasmin Meerhoff: »Verteilung und Zerstäubung. Zur Autorschaft computergestützter Literatur«. In: Digitale Literatur II. Hg. v. Hannes Bajohr u. Annette Gilbert. München 2021, S. 49–61.

- 24. Espen J. Aarseth: Cybertext. Perspectives on Ergodic Literature. Baltimore 1997, S. 129–141. Den Begriff erfunden hat allerdings David Wall: »The World-Wide Web as Cyborg Author«, 12. Dezember 1994, https://web.archive.org/web/20230330050045/http://www2.iath.virginia.edu/courses/encr481/wall.paper.html. Scott Rettberg hat cyborg authorship kürzlich explizit mit Bezug auf ChatGPT aufgerufen, um Mensch-KI-Kollaborationen zu beschreiben: Scott Rettberg: »Cyborg Authorship. Writing with AI. Part 1: The Trouble(s) with ChatGPT«. In: Electronic Book Review, 2. Juli 2023, DOI: 10.7273/5SY5-RX37

- 25. Racter: The Policeman’s Beard is Half Constructed. New York 1984.

- 26. Sotheby’s: »The Hypnotic Allure of the AI Art Generator«, YouTube, 8. Februar 2019, https://www.youtube.com/watch?v=Jjv3m5oWICA.

- 27. Vgl. Arthur I. Miller: »Creativity in the Age of AI: Computers and Artificial Neural Networks Are Redefining the Relationship Between Art and Science.« In: American Scientist 108.4 (2020), S. 244–249.

- 28. Vgl. Marian Mazzone u. Ahmed Elgammal: »Art, Creativity, and the Potential of Artificial Intelligence«. In: Arts 8.1 (2019), DOI: 10.3390/arts8010026.

- 29. Vgl. Rob Saunders u. Oliver Bown, »Computational Social Creativity«. In: Artificial Life 21.3 (2015), S. 366–378.

- 30. Alan M. Turing: »Computing Machinery and Intelligence«. In: Mind 59.236 (1950), S. 433–460, hier S. 433f.

- 31. Ich habe das kürzlich getan in: Hannes Bajohr, »Artifizielle und postartifizielle Texte. Über die Auswirkungen Künstlicher Intelligenz auf die Erwartungen an literarisches und nichtliterarisches Schreiben«. In: Sprache im technischen Zeitalter 1.243 (2023), S. 37–61. Im folgenden Abschnitt werden einige der dort aufgeführten Argumente wiederholt, um danach einem anderen Aspekt nachzugehen, nämlich dem des deiktischen Urteils.

- 32. Simone Natale: Deceitful Media. Artificial Intelligence and Social Life after the Turing Test. Oxford 2021, S. 2f.

- 33. Ebd., S. 7.

- 34. Ada Lovelace: »Translator’s Notes to M. Menebrea’s Memoir«. In Charles Babbage: Babbage’s Calculating Engines. Being a Collection of Papers Relating to Them, Their History, and Construction. Hg. v. Henry P. Babbage. Cambridge 2010, S. 21–50, hier S. 44.

- 35. Simone Natale u. Leah Henrickson, »The Lovelace Effect: Perceptions of Creativity in Machines.« New Media & Society, 4. März 2022 (online first), DOI: 10.1177/14614448221077278, S. 2. Hervorhebung i. Orig.

- 36. Leah Henrickson: Reading Computer-Generated Texts. Cambridge 2021, S. 4.

- 37. Henrickson: Reading Computer-Generated Texts, S. 58.

- 38. Daniel Dennett: »Intentional Systems«. In: The Journal of Philosophy 68.4 (1971), S. 87–106.

- 39. Susan Leigh Star: »The Structure of Ill-Structured Solutions. Boundary Objects and Heterogeneous Distributed Problem Solving«. In: Les Gasser u. Michael N. Huhns (Hg.): Distributed Artificial Intelligence. London 1989, S. 37–54, hier S. 41.

- 40. Nitasha Tiku: »The Google Engineer Who Thinks the Company’s AI Has Come to Life«. In: Washington Post, 11. Juni 2022.

- 41. Vgl. für dieses Argument Hannes Bajohr, »Keine Experimente. Künstlerische Künstliche Intelligenz«. In: Ders.: Schreibenlassen, S. 173–190.

- 42. Vgl. Joanna Krenz: »Do China’s Robots Dream the China Dream? Chinese Artificial Intelligence Poetry Between Aesthetics and Politics«. In: Andrea Riemenschnitter, Jessica Imbach u. Justyna Jaguscik (Hg.): Sinophone Utopias. Exploring Futures Beyond the China Dream. Amherst 2023, S. 41–60.

- 43. Siehe z. B. Jens Schröter: »Autorschaft aus dem Blickwinkel der Akteur-Netzwerk-Theorie«. In: Michael Wetzel (Hg.): Grundthemen der Literaturwissenschaft: Autorschaft. Berlin 2022, S. 625–631 sowie Martin Bartelmus u. Alexander Nebrig: »Schriftlichkeit und die Agentialität der Schrift. Eine Einleitung«. In: Martin Bartelmus u. Alexander Nebrig (Hg.): Schriftlichkeit: Aktivität, Agentialität und Aktanten der Schrift. Bielefeld 2022, S. 7–37.

- 44. Bruno Latour: Reassembling the Social. An Introduction to Actor-Network-Theory. Oxford 2005, S. 71.

- 45. Elena Esposito: Artificial Communication. How Algorithms Produce Social Intelligence. Cambridge / MA 2022, Kap. 1; dasselbe Argument nun auch in: Elena Esposito: Kommunikation mit unverständlichen Maschinen. Wien 2024. Siehe auch Moritz Hiller: »Es gibt keine Sprachmodelle«. In: Davide Giuriato, Claas Morgenroth u. Sandro Zanetti (Hg.): Noten zum »Schreiben«. Paderborn 2023, S. 279–285. Hinzuweisen wäre an dieser Stelle darauf, dass »intentional« und »von Menschen hergestellt« nicht identisch sind: Eine intentionale Maschine ist ja mit Lemoine gerade denkbar, ebenso gibt es verschiedene Techniken nichtintentionalen Schreibens, das von Menschen stammt. Und von beiden ist der Status »anerkannt als Teil einer Urteilsgemeinschaft«, auf die ich hier abhebe, wiederum zu scheiden. All diese Differenzen kann eine bloß auf »Anschlusskommunikation« ausgerichtete Systemtheorie nicht überzeugend erfassen, da sie sie von vornherein übergeht.

- 46. Diese Kritik gilt zugleich für alle »konservativen« Ansätze, die echte Intentionalität als Kriterium eines Begriffs von Computerautorschaft verlangen, vgl. René Van Woudenberg, Chris Ranalli u. Daniel Bracker: »Authorship and ChatGPT: A Conservative View«. In: Philosophy & Technology 37.1 (2024), DOI: 10.1007/s13347-024-00715-1. Auch hier sind Feedbackprozesse und Erwartungsverschiebungen von vornherein ausgeschlossen.

- 47. Siehe Bajohr: »Artifizielle und postartifizielle Texte«.

- 48. Allerdings fällt im Fall des Duchamp-Retweets auf, dass er, im Gegensatz zu anderen, sofortigen Retweets dieses Accounts, erst zwei Tage nach dem Original-Tweet gepostet wurde, also kaum wirklich automatisiert gewesen war – hier scheint der Mensch Franková noch ganz direkt hinter der Deixis zu stehen, statt für ihre Automatisierung per Programmierung nur indirekt verantwortlich zu sein.

- 49. In der Tat steht eine ernsthafte anerkennungstheoretische Untersuchung von künstlicher Intelligenz noch aus.

Kommentar hinzufügen